LangChain na Prática: Da POC à Produção Empresarial

LangChain além do básico: arquitetura empresarial completa, do protótipo à produção. Case real com 50% melhoria em performance. Guia para líderes técnicos.

Como Transformar Ideias de IA em Soluções Reais que Geram Valor

Quando uma empresa parceira me procurou com o desafio de melhorar a performance do time de pre-vendas, o problema era claro: as taxas de conversão estavam estagnadas e os vendedores perdiam tempo valioso se preparando para cada ligação. A solução que desenvolvemos usando LangChain não apenas resolveu o problema inicial, mas criou um sistema que se auto-aperfeiçoa continuamente, resultando em uma melhoria de 50% na taxa de conversão.

Este artigo compartilha a arquitetura conceitual desta implementação, mostrando como LangChain vai muito além de um simples wrapper para LLMs, tornando-se uma verdadeira plataforma de orquestração de inteligência artificial empresarial.

O Desafio: Além da Automação Simples

O desafio não era apenas automatizar respostas, mas criar um sistema inteligente que:

Analisasse dados contextuais de cada prospect antes da ligação

Capacitasse vendedores com insights personalizados

Aprendesse continuamente com cada interação

Mantivesse qualidade mesmo com volume crescente

Aqui é onde LangChain se mostrou fundamental. Não precisávamos apenas de um chatbot, mas de uma arquitetura que pudesse orquestrar múltiplas fontes de dados, diferentes modelos de IA e workflows complexos.

Arquitetura Conceitual: Beyond Simple Chains

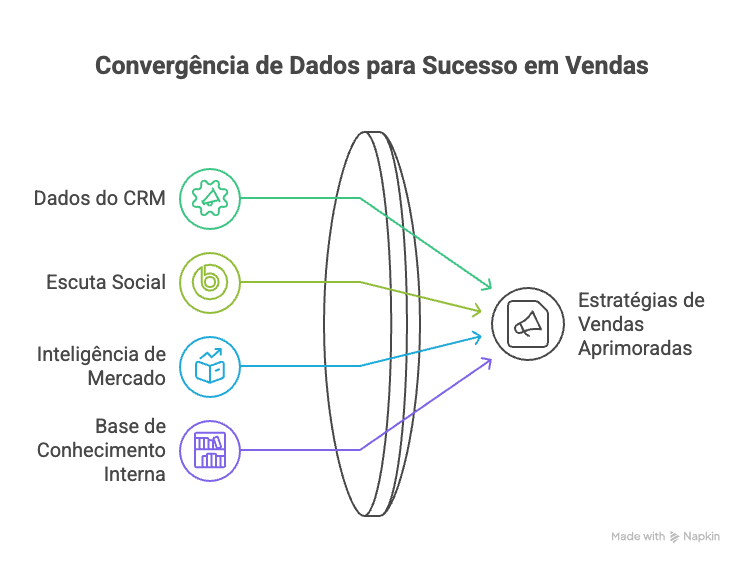

Layer 1: Data Ingestion & Context Building

O primeiro desafio foi criar um sistema que pudesse processar informações de múltiplas fontes:

Sources Integradas:

CRM data (histórico, perfil, interações anteriores)

Social listening (LinkedIn, empresa do prospect)

Market intelligence (setor, concorrentes, tendências)

Internal knowledge base (objections handling, success cases)

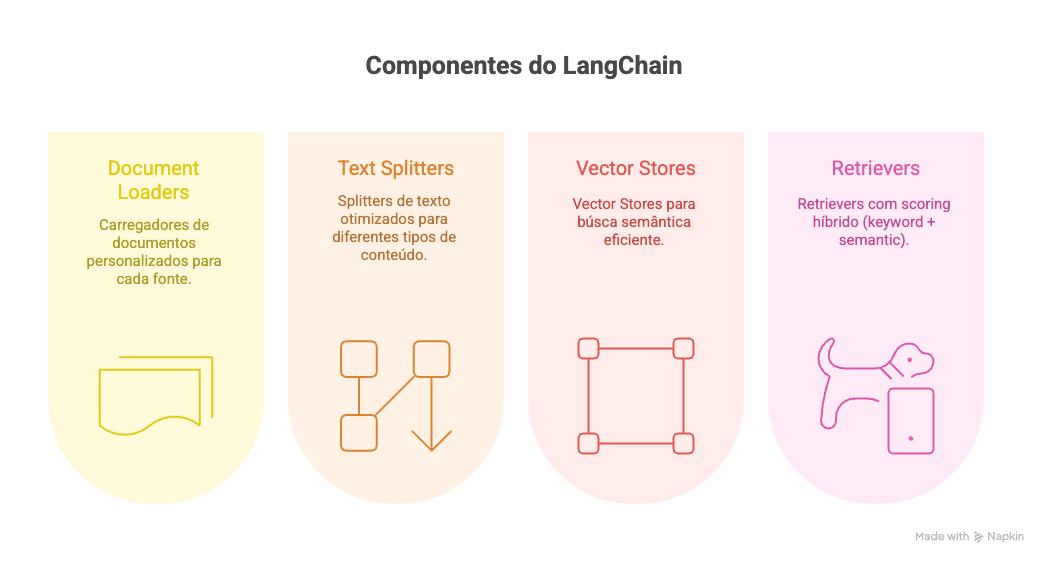

LangChain Components:

Document Loaders customizados para cada fonte

Text Splitters otimizados para diferentes tipos de conteúdo

Vector Stores para búsca semântica eficiente

Retrievers com scoring híbrido (keyword + semantic)

Layer 2: Intelligence Orchestration

Esta é onde a magia acontece. Usando LangChain's Chain abstraction, criamos um workflow que:

Pre-Call Intelligence Chain:

Context Retrieval: Busca informações relevantes sobre o prospect

Competitive Analysis: Identifica concorrentes e positioning gaps

Objection Prediction: Antecipa possíveis resistências baseado em padrões históricos

Personalization: Gera talking points específicos para aquele prospect

Resource Recommendation: Sugere materiais de apoio relevantes

Real-time Support Chain:

Call Monitoring: Processa áudio em tempo real (quando permitido)

Sentiment Analysis: Monitora engagement e resistência

Dynamic Prompting: Sugere próximos passos baseado no flow da conversa

Resource Fetching: Busca informações adicionais conforme necessário

Layer 3: Continuous Learning Loop

Aqui está o diferencial: um sistema que se aperfeiçoa automaticamente.

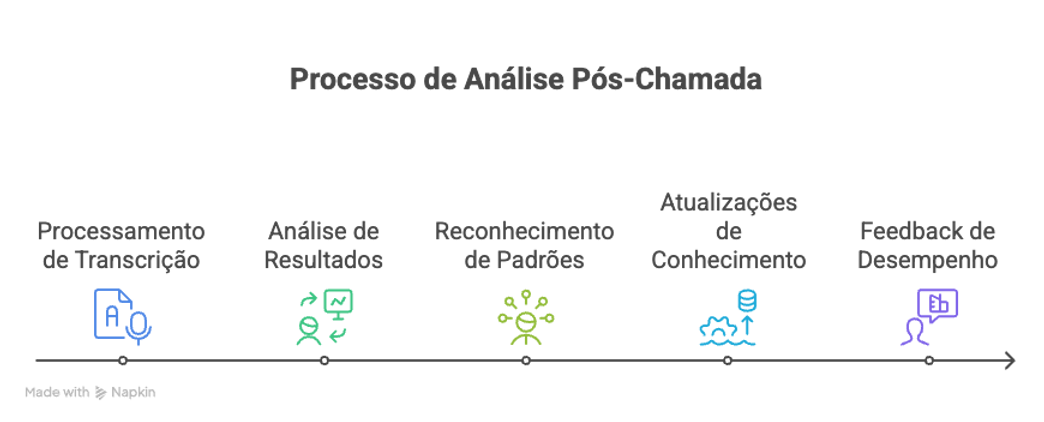

Post-Call Analysis Chain:

Transcription Processing: Converte áudio em texto estruturado

Outcome Analysis: Correlaciona ações com resultados

Pattern Recognition: Identifica o que funciona (e o que não funciona)

Knowledge Updates: Atualiza base de conhecimento automaticamente

Performance Feedback: Gera insights para próximas interações

Conceitos Arquiteturais Fundamentais

Memory Management: Além do Contexto Simples

LangChain's memory systems permitiram implementar diferentes tipos de "lembrança":

Short-term Memory: Contexto da conversa atual

Long-term Memory: Histórico de interações com aquele prospect

Semantic Memory: Padrões aprendidos de conversas similares

Procedural Memory: Best practices atualizadas automaticamente

Chain Composition: Modularidade em Ação

Em vez de um monólito, criamos chains modulares:

Specialized Chains:

ProspectAnalysisChain: Análise profunda do prospect

CompetitorIntelChain: Intelligence competitiva

ObjectionHandlingChain: Tratamento de objeções

PersonalizationChain: Customização de abordagem

LearningChain: Atualização contínua de conhecimento

Meta-Chains:

PreCallOrchestratorChain: Coordena preparação

RealTimeAssistantChain: Suporte durante call

PostCallLearningChain: Processamento pós-call

Error Handling & Fallbacks: Produção-Ready

Implementamos múltiplas camadas de redundância:

Model Fallbacks: GPT-4 → GPT-3.5 → Local model

Data Source Fallbacks: Primary API → Cache → Manual input

Chain Fallbacks: Specific chain → Generic chain → Human handoff

Quality Gates: Validation em cada step crítico

Business Impact: Métricas que Importam

Resultados Quantitativos:

50% improvement na taxa de conversão

70% reduction no tempo de preparação por call

90% consistency na qualidade de discovery calls

Real-time insights disponíveis em 100% das interações

Beneficios Qualitativos:

Vendedores mais confiantes e preparados

Onboarding de novos vendedores 3x mais rápido

Knowledge capture automático (não depende mais de memory individual)

Continuous improvement sem intervenção manual

Lições Arquiteturais: Do Protótipo à Produção

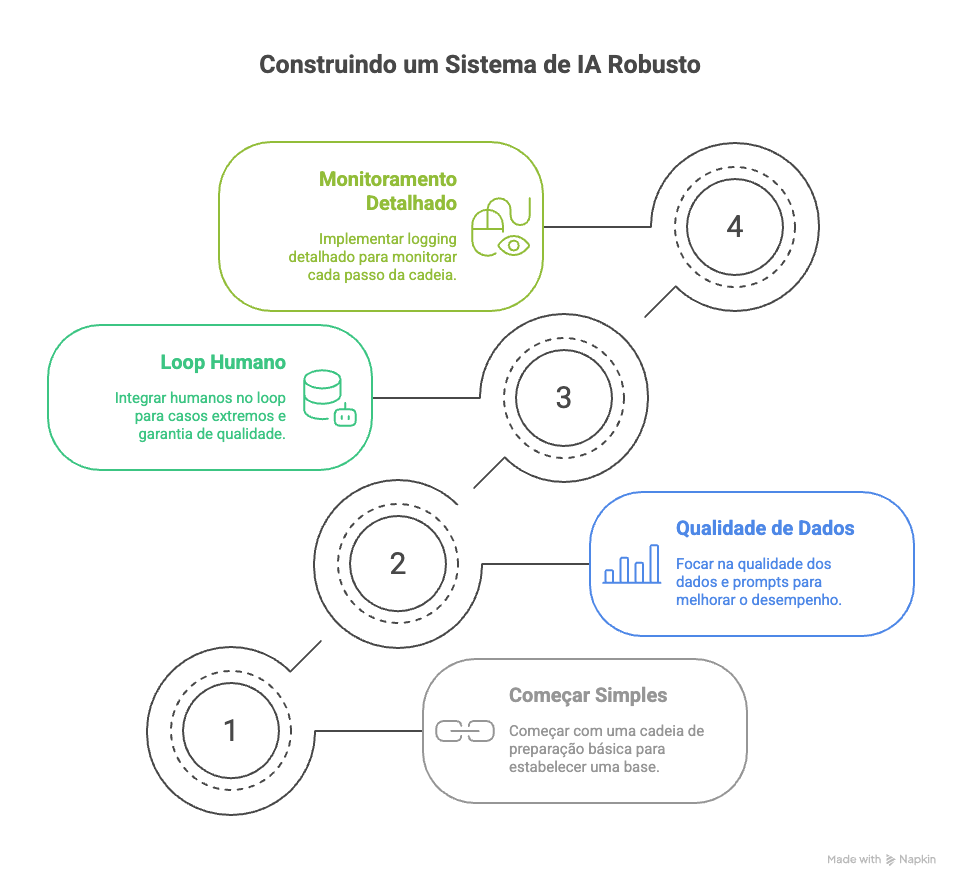

1. Start Simple, Scale Smart

Começamos com um chain simples de preparação. Só depois adicionamos real-time support e learning loops. LangChain's modular architecture permitiu essa evolução orgânica.

2. Data Quality > Model Sophistication

95% do sucesso veio da qualidade dos dados e prompts, não do modelo usado. LangChain facilitou a experimentação com diferentes data sources e prompt strategies.

3. Human-in-the-Loop é Essencial

Mesmo com IA avançada, mantivemos humans no loop para edge cases e quality assurance. LangChain's callback system facilitou essa integração.

4. Monitoring é Tão Importante Quanto Funcionalidade

Implementamos logging detalhado de cada chain step. LangChain's built-in callbacks salvaram semanas de development.

Performance & Scalability Considerations

Latency Optimization:

Parallel Chain Execution onde possível

Aggressive Caching de embeddings e frequent queries

Model Selection baseada em latency requirements

Async Processing para non-critical chains

Cost Management:

Smart Routing para diferentes modelos baseado na complexity

Batch Processing para operações que não precisam ser real-time

Cache-First Strategy para queries repetitivas

Token Optimization em todos os prompts

Next Steps: Scaling the Architecture

Esta implementação abriu caminho para expansões:

Multi-Department Rollout: Adaptando para Marketing e Customer Success

Industry Customization: Vertical-specific knowledge bases

Advanced Analytics: Predictive modeling baseado nos dados capturados

Integration Expansion: Conexão com mais data sources e tools

Conclusão: LangChain como Enterprise Platform

O que aprendemos é que LangChain não é apenas uma biblioteca para conectar com LLMs. É uma verdadeira plataforma para construir intelligent business processes. A arquitetura modular, combined with robust memory systems e flexible chain composition, permite criar soluções que realmente scale e se adaptam às necessidades específicas de cada negócio.

Para CTOs e líderes técnicos considerando LangChain: foquem na arquitetura de dados primeiro, modularize from day one, e sempre planejem para learning loops. A tecnologia está pronta para produção empresarial - o desafio agora é aplicá-la estrategicamente.

Este artigo faz parte de uma série sobre implementação prática de Generative AI em ambientes empresariais. No próximo artigo, vamos explorar as decisões estratégicas entre OpenAI e modelos open-source para diferentes casos de uso.

Artigo originalmente publicado em www.guilhermefavaron.com.br