MCP: Entendendo o Model Context Protocol e Seu Impacto na Transformação da IA

Introdução: A Evolução dos LLMs e a Necessidade de Padronização

Desde o ChatGPT até o Claude e outros assistentes baseados em IA, esses modelos revolucionaram nossa capacidade de processar e gerar linguagem natural. No entanto, um desafio crítico tem limitado seu potencial: a incapacidade de interagir efetivamente com fontes externas de dados e ferramentas.

É neste contexto que surge o Model Context Protocol (MCP), uma inovação que promete expandir drasticamente as capacidades dos LLMs, permitindo que se conectem de forma padronizada com o mundo exterior. Mas o que exatamente é o MCP, como ele funciona, e por que está gerando tanto entusiasmo no setor de tecnologia?

Neste artigo, vamos mergulhar profundamente no universo do MCP, desvendando seus conceitos fundamentais, sua arquitetura, aplicações práticas e o impacto transformador que promete ter no desenvolvimento de agentes de IA mais poderosos e úteis.

O Que é o MCP (Model Context Protocol)?

O Model Context Protocol (MCP) é um protocolo aberto que padroniza a forma como aplicações fornecem contexto aos LLMs. Em termos simples, podemos pensar no MCP como uma "porta USB-C para aplicações de IA". Assim como o USB-C fornece uma maneira padronizada de conectar dispositivos a diversos periféricos e acessórios, o MCP proporciona uma forma padronizada de conectar modelos de IA a diferentes fontes de dados e ferramentas.

Criado pela Anthropic (empresa desenvolvedora do Claude), o MCP resolve um problema fundamental dos LLMs: por si só, eles são incapazes de realizar ações significativas no mundo real. Um LLM tradicional pode gerar texto fluente, responder perguntas e demonstrar compreensão linguística impressionante, mas não pode, por exemplo, enviar um e-mail, pesquisar informações atualizadas na internet ou interagir com APIs externas.

O MCP muda esse cenário, fornecendo uma camada intermediária que permite aos LLMs se conectarem a ferramentas e serviços externos de maneira consistente e segura.

A Limitação Fundamental dos LLMs

Para entender verdadeiramente a importância do MCP, precisamos primeiro reconhecer as limitações inerentes aos LLMs em seu estado atual:

LLMs São Essencialmente Preditores de Texto

Em sua essência, um LLM é um modelo matemático treinado para prever o próximo token (palavra ou parte de palavra) em uma sequência. Por exemplo, se você digitar "Meu Grande Gordo Casamento", o modelo prevê que a próxima palavra será provavelmente "Grego". Esta capacidade de previsão de texto, embora impressionante, é fundamentalmente limitada.

Sem Conexão com o Mundo Externo

Os LLMs não possuem capacidade nativa de interagir com o mundo exterior. Não podem navegar na web, acessar bancos de dados, chamar APIs ou realizar ações como enviar e-mails. Estão limitados ao conhecimento adquirido durante seu treinamento e à conversa atual com o usuário.

A Evolução: LLMs + Ferramentas

A primeira tentativa de superar essas limitações foi conectar LLMs a ferramentas específicas. Por exemplo, quando o ChatGPT ou o Claude podem pesquisar na internet, isso acontece porque foram conectados a uma ferramenta de busca. Cada ferramenta adiciona uma capacidade específica, como:

Pesquisa na web

Acesso a dados em tempo real

Capacidade de ler arquivos

Interação com APIs específicas

No entanto, esta abordagem de "colar" ferramentas aos LLMs apresenta desafios significativos:

Complexidade técnica: Cada integração requer trabalho personalizado

Inconsistência: Cada fornecedor implementa integrações de maneira diferente

Falta de escalabilidade: Adicionar muitas ferramentas torna-se inviável

Manutenção: Alterações nas APIs externas podem quebrar as integrações

É precisamente este cenário que o MCP visa solucionar, oferecendo um padrão unificado para conexões entre LLMs e ferramentas externas.

Como Funciona o MCP: Arquitetura e Componentes

O MCP segue uma arquitetura cliente-servidor que estabelece uma comunicação padronizada entre aplicações de IA e servidores que fornecem recursos ou funcionalidades. Vamos entender os componentes principais:

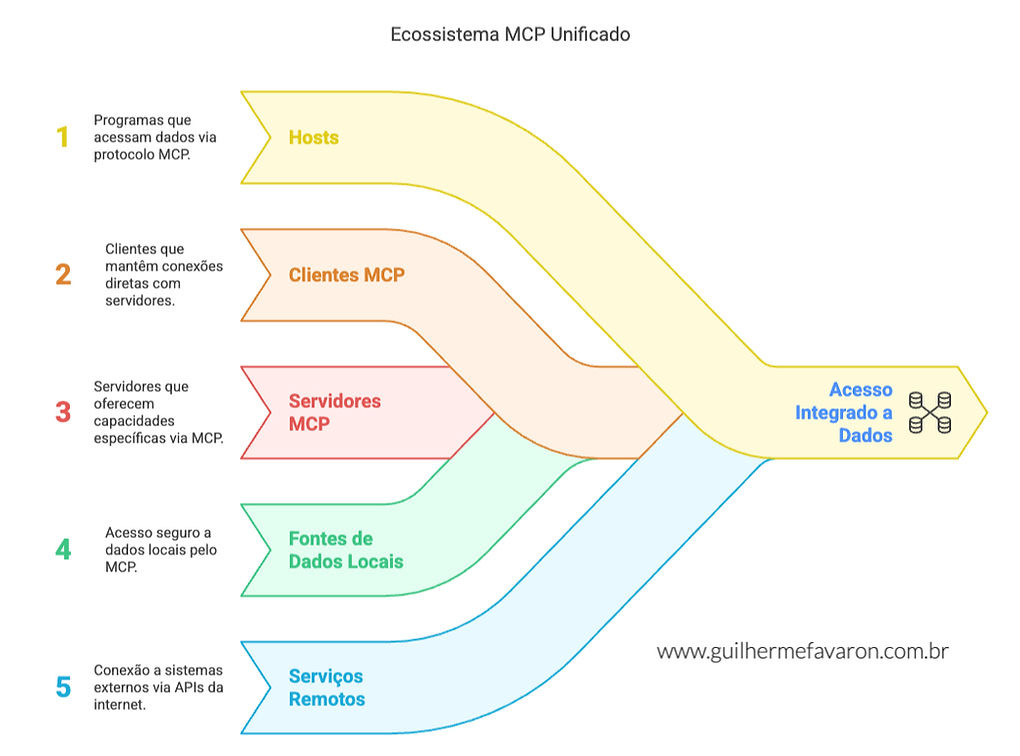

Componentes Essenciais do Ecossistema MCP

Hosts: Programas como Claude Desktop, IDEs ou ferramentas de IA que desejam acessar dados através do MCP. São os programas ou aplicativos que o usuário utiliza para interagir com a IA. Por exemplo:

O aplicativo Claude Desktop no seu computador, onde você conversa diretamente com a IA

Um editor de código como VS Code com extensões de IA

O Microsoft Word com um assistente de escrita integrado

Clientes MCP: Clientes do protocolo que mantêm conexões 1:1 com servidores. São como "tradutores" que permitem que o host se comunique com os servidores. Imagine-os como adaptadores que:

Transmitem suas perguntas para os serviços corretos

Recebem as respostas e as trazem de volta

Semelhante a um controle remoto que se conecta a um dispositivo específico

Servidores MCP: Programas leves que expõem capacidades específicas através do protocolo MCP padronizado. Ou seja, são pequenos programas especializados que executam tarefas específicas quando solicitados. Por exemplo:

Um servidor meteorológico que sabe buscar previsões do tempo

Um servidor para Google Drive que permite acessar seus documentos

Um servidor GitHub que pode verificar código e commits

Um servidor de e-mail que envia mensagens quando solicitado

Fontes de Dados Locais: Arquivos, bancos de dados e serviços do computador que os servidores MCP podem acessar com segurança. Ou seja, são informações armazenadas no seu próprio dispositivo às quais o MCP pode acessar, como:

Seus documentos no computador

Planilhas salvas localmente

Imagens na sua galeria

Um banco de dados SQLite no seu laptop

Serviços Remotos: Sistemas externos disponíveis pela internet (através de APIs) aos quais os servidores MCP podem se conectar. Ou seja, são sistemas e dados online que o MCP pode acessar via internet, como:

API do Twitter para ver tendências atuais

API de previsão do tempo para obter o clima em tempo real

Serviços de tradução online

Um sistema CRM empresarial na nuvem

Fluxo de Comunicação

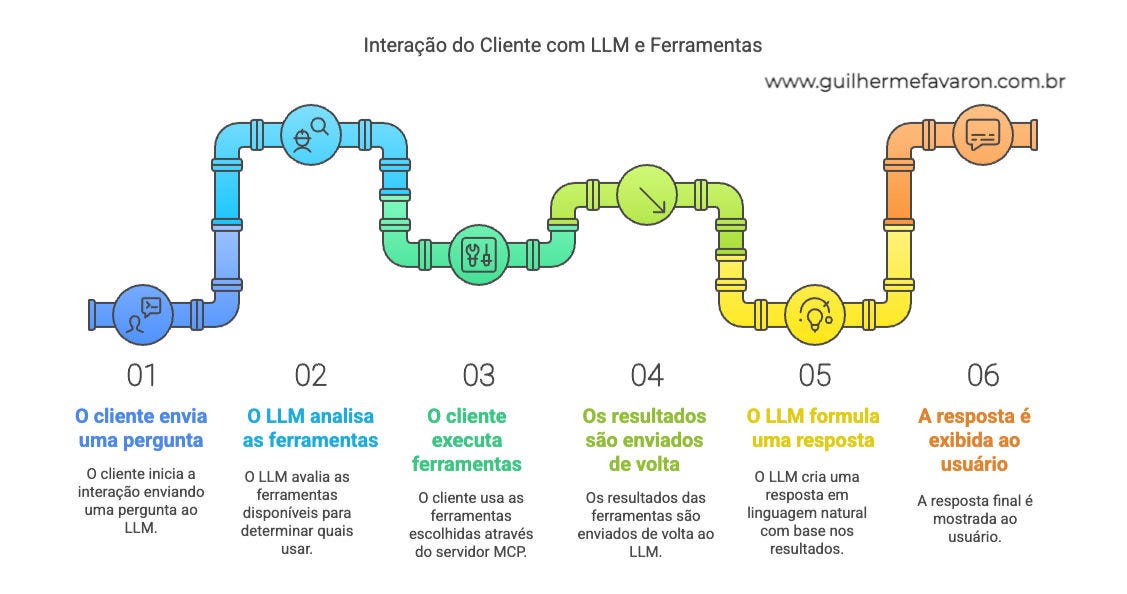

O fluxo de comunicação típico no MCP segue estes passos:

O cliente envia uma pergunta ao LLM

O LLM analisa as ferramentas disponíveis e decide qual(is) utilizar

O cliente executa a(s) ferramenta(s) escolhida(s) através do servidor MCP

Os resultados são enviados de volta ao LLM

O LLM formula uma resposta em linguagem natural

A resposta é exibida ao usuário

Camadas do Protocolo

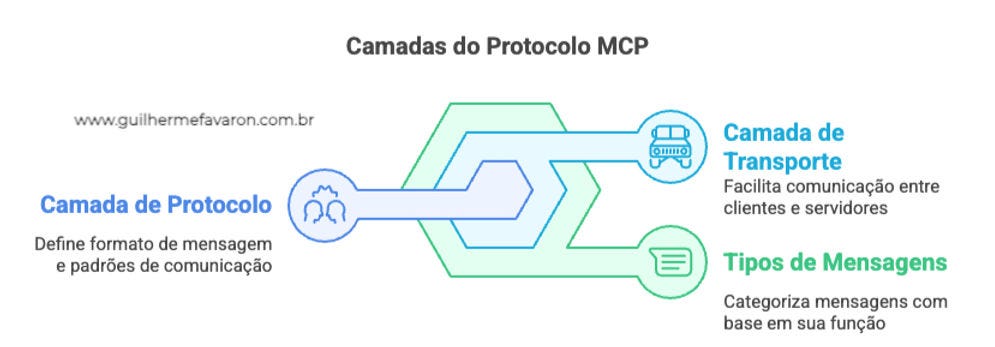

O protocolo MCP opera em várias camadas:

Camada de Protocolo: Responsável pelo formato das mensagens, vinculação de solicitação/resposta e padrões de comunicação

Camada de Transporte: Gerencia a comunicação real entre clientes e servidores através de mecanismos como stdio (entrada/saída padrão) ou HTTP com SSE (Server-Sent Events)

Tipos de Mensagens: Inclui Solicitações (que esperam uma resposta), Resultados (respostas bem-sucedidas), Erros (indicam falha) e Notificações (mensagens unidirecionais)

Ciclo de Vida da Conexão

Uma conexão MCP típica segue estas etapas:

Inicialização: O cliente envia uma solicitação com versão e capacidades, o servidor responde, o cliente confirma

Troca de Mensagens: Padrões de solicitação-resposta e notificações fluem entre cliente e servidor

Encerramento: A conexão pode ser encerrada de forma limpa ou devido a condições de erro

Capacidades Oferecidas pelo MCP

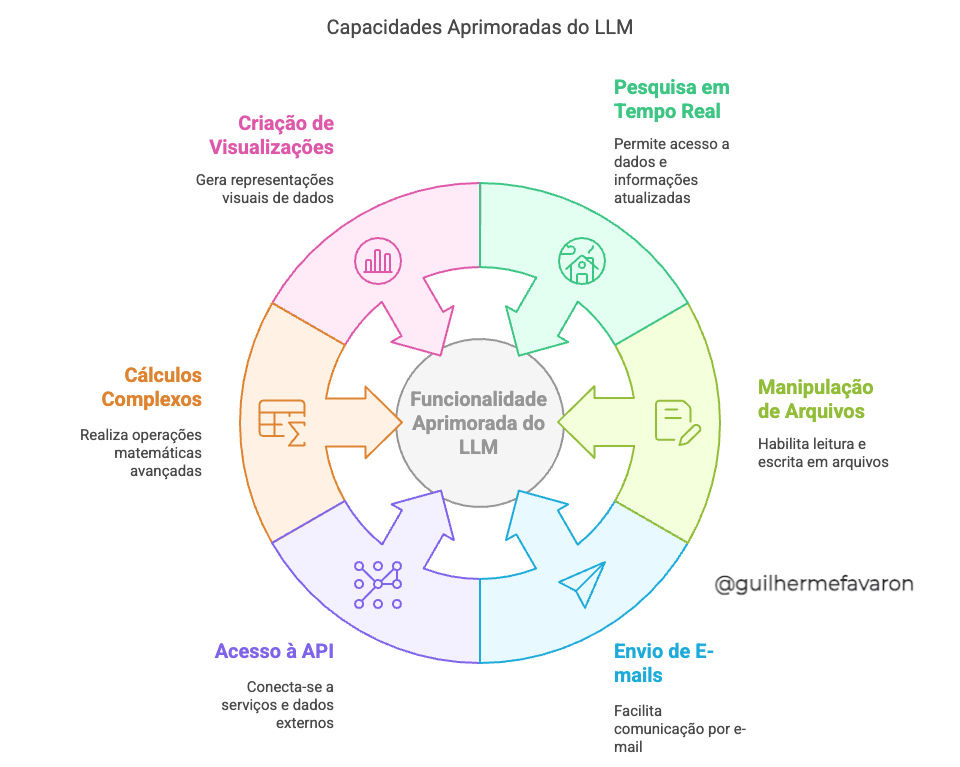

O MCP possibilita três tipos principais de capacidades:

1. Recursos (Resources)

Dados semelhantes a arquivos que podem ser lidos por clientes, como respostas de API ou conteúdo de arquivos. Estes recursos permitem que o LLM acesse informações externas de maneira estruturada.

2. Ferramentas (Tools)

Funções que podem ser chamadas pelo LLM (com aprovação do usuário). As ferramentas são o componente mais poderoso do MCP, permitindo que o modelo realize ações concretas, como:

Pesquisar dados em tempo real

Escrever em arquivos

Enviar e-mails

Acessar APIs externas

Realizar cálculos complexos

Criar visualizações

3. Prompts

Templates pré-escritos que ajudam os usuários a realizar tarefas específicas. Estes prompts padronizados podem melhorar a consistência da interação do usuário com o LLM.

Implementação Prática do MCP

Para ilustrar como o MCP funciona na prática, vamos considerar um exemplo simples: um servidor MCP que fornece informações meteorológicas.

Exemplo: Servidor Meteorológico MCP

Este servidor exporia duas ferramentas principais:

get-alerts: Obtém alertas meteorológicos para um estado dos EUA

get-forecast: Obtém previsão do tempo para uma localização específica

O código para este servidor seria algo como:

from typing import Any

import httpx

from mcp.server.fastmcp import FastMCP

# Inicializa servidor FastMCP

mcp = FastMCP("weather")

# Constantes

NWS_API_BASE = "https://api.weather.gov"

USER_AGENT = "weather-app/1.0"

@mcp.tool()

async def get_alerts(state: str) -> str:

"""Obtém alertas meteorológicos para um estado dos EUA.

Args:

state: Código de duas letras do estado dos EUA (ex: CA, NY)

"""

url = f"{NWS_API_BASE}/alerts/active/area/{state}"

data = await make_nws_request(url)

# Processar e formatar os dados...

return formatted_alerts

@mcp.tool()

async def get_forecast(latitude: float, longitude: float) -> str:

"""Obtém previsão do tempo para uma localização.

Args:

latitude: Latitude da localização

longitude: Longitude da localização

"""

# Obter e processar dados de previsão do tempo...

return formatted_forecast

# Inicializa e executa o servidor

mcp.run(transport='stdio')

Conectando ao Cliente

Para usar este servidor, um cliente MCP (como o Claude Desktop) precisa ser configurado para se conectar a ele. No Claude Desktop, isso é feito editando o arquivo de configuração para incluir o servidor:

{

"mcpServers": {

"weather": {

"command": "python",

"args": ["/caminho/para/weather.py"]

}

}

}

Interação com o Usuário

Uma vez configurado, o usuário pode fazer perguntas como:

"Qual é o clima no Rio de Janeiro?"

"Existem alertas de clima severo em São Sebastião?"

O Claude analisará estas perguntas, determinará qual ferramenta usar (get-forecast ou get-alerts), chamará a ferramenta apropriada através do servidor MCP, e então formulará uma resposta natural integrando os dados obtidos.

Benefícios e Impacto do MCP

A adoção do MCP traz numerosos benefícios que transformam fundamentalmente o que é possível fazer com LLMs:

1. Acesso a Dados em Tempo Real

Ao permitir que LLMs se conectem a fontes externas, o MCP supera uma das maiores limitações desses modelos: sua incapacidade de acessar informações atualizadas. Um LLM equipado com MCP pode fornecer previsões meteorológicas atuais, cotações do mercado financeiro, notícias recentes ou qualquer outro dado disponível via API.

2. Automação de Tarefas Complexas

O MCP permite que os LLMs realizem sequências de ações no mundo real, facilitando automações complexas. Por exemplo, um LLM com acesso a ferramentas MCP poderia:

Analisar e-mails, extrair datas importantes e adicioná-las ao seu calendário

Buscar informações em múltiplas fontes, compará-las e gerar relatórios

Interagir com várias APIs para realizar um fluxo de trabalho completo

3. Segurança e Controle de Acesso

O MCP foi projetado com segurança em mente. Os usuários mantêm controle sobre quais ferramentas o LLM pode acessar e aprovam explicitamente as ações antes que sejam executadas. Isto significa que você pode aproveitar o poder dos LLMs sem comprometer a segurança dos seus dados ou sistemas.

4. Interoperabilidade e Padronização

Como um protocolo aberto, o MCP promove a interoperabilidade entre diferentes implementações de LLM e ferramentas. Isto reduz a fragmentação no ecossistema de IA e permite que desenvolvedores criem ferramentas que funcionem com múltiplos modelos e aplicações.

5. Experiência de Usuário Aprimorada

Para usuários finais, o MCP proporciona uma experiência mais fluida e capaz. Em vez de alternar entre vários aplicativos para realizar tarefas diferentes, os usuários podem simplesmente pedir ao LLM que execute as ações necessárias, resultando em um fluxo de trabalho mais eficiente e natural.

O Futuro do MCP e Suas Aplicações

O MCP está em seus estágios iniciais, mas seu potencial para transformar a maneira como interagimos com a IA é vasto. Algumas das aplicações e desenvolvimentos futuros que podemos antecipar incluem:

Assistentes Pessoais Verdadeiramente Capazes

Com o MCP, assistentes baseados em IA como o Claude podem evoluir de meros conversadores para ferramentas verdadeiramente úteis que gerenciam e-mails, organizam documentos, automatizam tarefas repetitivas e interagem com numerosos serviços online em seu nome.

Integração com DevOps e Desenvolvimento de Software

Desenvolvedores podem usar LLMs potencializados pelo MCP para:

Analisar bases de código complexas

Debugar problemas

Implementar automações de CI/CD

Interagir diretamente com sistemas de controle de versão e ferramentas de desenvolvimento

IA para Análise e Visualização de Dados

O MCP permite que LLMs acessem, processem e visualizem dados complexos, tornando-os poderosas ferramentas para análise de dados. Imagine pedir ao seu assistente de IA para conectar-se ao seu banco de dados, realizar análises complexas e gerar visualizações informativas - tudo através de comandos em linguagem natural.

Agentes de IA Especializados

À medida que o ecossistema MCP se desenvolve, podemos esperar ver agentes de IA especializados para setores específicos, como:

Assistentes médicos que acessam registros de pacientes e literatura médica

Analistas financeiros virtuais que monitoram mercados e geram relatórios

Assistentes educacionais que se conectam a recursos de aprendizagem e sistemas de gestão de sala de aula

Integração com IoT e Automação Residencial

O MCP pode permitir que LLMs controlem dispositivos IoT e sistemas de automação residencial, abrindo caminho para casas inteligentes verdadeiramente intuitivas que respondem a comandos naturais e aprendem as preferências dos usuários.

Desafios e Considerações

Apesar de seu enorme potencial, o MCP também enfrenta desafios significativos:

Segurança e Privacidade

Dar aos LLMs acesso a ferramentas externas levanta questões importantes sobre segurança e privacidade. Os desenvolvedores precisam implementar mecanismos robustos para evitar abusos e proteger dados sensíveis.

Complexidade Técnica

A implementação do MCP, especialmente para ferramentas e integrações complexas, requer experiência técnica significativa. Simplificar este processo será crucial para a adoção generalizada.

Padronização e Compatibilidade

Como um protocolo relativamente novo, o MCP ainda está evoluindo. Garantir compatibilidade entre diferentes implementações e versões será um desafio contínuo.

Solução de Problemas e Manutenção

Sistemas baseados em MCP envolvem múltiplas camadas de software (cliente, servidor, APIs externas), o que pode tornar a solução de problemas mais complexa quando algo dá errado.

Como Começar com o MCP

Se você está interessado em explorar o MCP, há várias maneiras de começar:

Para Usuários

A maneira mais simples de experimentar o MCP é através do Claude Desktop, que oferece suporte integrado ao protocolo. Você pode configurá-lo para usar servidores MCP pré-construídos e experimentar as capacidades expandidas que eles fornecem.

Para Desenvolvedores

Se você é um desenvolvedor interessado em criar servidores ou clientes MCP:

Comece com a documentação oficial: O site do Model Context Protocol oferece guias detalhados e tutoriais.

Experimente os exemplos: Existem vários servidores de exemplo disponíveis que você pode estudar e modificar.

Escolha seu SDK: Existem SDKs para várias linguagens, incluindo Python, Node.js, Java, Kotlin e C#.

Comece com algo simples: Crie um servidor básico que exponha uma ou duas ferramentas simples antes de avançar para implementações mais complexas.

Conclusão: O MCP como Catalisador para a "Revolução" da IA

O Model Context Protocol representa um avanço significativo na evolução dos Modelos de Linguagem de Grande Escala. Ao fornecer um método padronizado para conectar LLMs a ferramentas e dados externos, o MCP supera uma limitação fundamental que tem restringido o potencial desses modelos desde sua criação.

Estamos apenas começando a explorar as possibilidades que o MCP abre. À medida que mais desenvolvedores adotam o protocolo e criam servidores inovadores, podemos esperar ver assistentes de IA transformarem-se de meros chatbots em agentes verdadeiramente capazes que podem ajudar com uma ampla gama de tarefas práticas.

O futuro da IA não está apenas em modelos maiores ou mais inteligentes, mas em modelos que podem interagir efetivamente com o mundo ao seu redor. O MCP é um passo crucial nessa direção, e seu impacto sobre como usamos e nos beneficiamos da IA provavelmente será profundo e duradouro.

Seja você um usuário curioso, um desenvolvedor ambicioso ou um líder empresarial visionário, vale a pena prestar atenção ao MCP e ao ecossistema emergente que está construindo. As possibilidades são praticamente ilimitadas, e estamos apenas começando a arranhá-las.

Este artigo foi produzido com base em pesquisa detalhada sobre o Model Context Protocol, incluindo documentação oficial e recursos educacionais disponíveis até março de 2025. As capacidades e implementações específicas podem evoluir à medida que o protocolo amadurece.

Link para Referência: https://docs.anthropic.com/en/docs/agents-and-tools/mcp