OpenAI vs Modelos Open-Source: Decisões Estratégicas para CTOs

OpenAI vs modelos open-source: guia completo para CTOs. Arquitetura híbrida, análise de custos e cases práticos. Framework baseado em experiência real.

Além do Custo: Como Escolher a Arquitetura Certa para Cada Caso de Uso

Quando desenvolvi mais de 22 aplicações de IA para o portfólio MindApps.ai, uma das decisões mais críticas não foi qual tecnologia usar, mas quando usar cada uma. A escolha entre OpenAI e modelos open-source como Llama 4.0 vai muito além do custo por token - envolve estratégia de produto, compliance, performance e sustentabilidade a longo prazo.

Este artigo compartilha as lições aprendidas ao implementar ambas as abordagens em cenários reais de produção, oferecendo um framework de decisão baseado em casos práticos e métricas reais de performance.

O falso dilema: Não é uma escolha binária

A primeira lição que aprendi foi que a questão não é "OpenAI ou open-source", mas sim "OpenAI e open-source para quê". Diferentes casos de uso demandam diferentes abordagens, e a arquitectura mais robusta frequentemente combina ambas as estratégias.

Em uma empresa parceira especializada em processamento de documentos legais, implementamos uma arquitetura híbrida onde ChatGPT 5.0 processa análises complexas que exigem raciocínio sofisticado, enquanto Llama 4.0 executa tarefas de classificação e extração de dados que precisam acontecer on-premises por questões de compliance.

Framework de decisão: Critérios além do óbvio

Complexidade vs Espectros de Controle

O primeiro critério de avaliação deve considerar a complexidade da tarefa versus a necessidade de controle sobre o modelo. Esta análise determina não apenas qual tecnologia usar, mas como arquitetar a solução.

Para tarefas que exigem raciocínio complexo, nuance contextual e capacidade de generalização, a sofisticação do ChatGPT 5.0 ainda é superior. Observei isso especialmente em aplicações que envolvem análise de sentimentos em contextos ambíguos ou geração de conteúdo que precisa manter consistência tonal ao longo de documentos extensos.

Por outro lado, para tarefas bem definidas onde é possível criar datasets de treinamento específicos, modelos open-source oferecem vantagens significativas. O controle total sobre o modelo permite otimizações que resultam em performance superior para aquele domínio específico.

Características de Performance

As características de performance variam drasticamente entre as diferentes abordagens, e compreender essas nuances é fundamental para decisões arquiteturais acertadas.

Latência e throughput:

ChatGPT 5.0 oferece latência consistente mas limitada por rate limits

Llama 4.0 auto-hospedado permite controle total sobre performance / rendimento

Modelos open-source menores podem ser otimizados para latência ultra-baixa

Qualidade e consistência:

OpenAI mantém qualidade mais previsível entre diferentes casos de uso

Open-source pode superar em domínios específicos após fine-tuning

Híbrido permite usar strengths de cada abordagem

Considerações financeiras

O modelo econômico vai muito além do custo por token e deve considerar o total cost of ownership ao longo do ciclo de vida da aplicação.

Para aplicações com volume previsível e constante, o investimento inicial em infraestrutura para modelos open-source frequentemente se paga em 6-12 meses. Implementei essa análise em uma aplicação de customer support onde o volume mensal de 500K+ tokens tornava o custo da OpenAI proibitivo a longo prazo.

Entretanto, para aplicações com volume variável ou casos de uso experimentais, o modelo pay-per-use da OpenAI oferece flexibilidade financeira importante. O custo de manter infraestrutura idle para picos ocasionais pode ser significativamente maior que o custo variável por token.

Padrões Arquiteturais: abordagem híbrida

Arquitetura de roteamento de modelo

Uma das arquiteturas mais eficazes que desenvolvi utiliza routing inteligente baseado na complexidade da query. O sistema analisa a entrada e direciona automaticamente para o modelo mais adequado.

A implementação envolve um classificador lightweight que avalia queries em tempo real. Queries simples e estruturadas vão para modelos open-source otimizados, enquanto requests que exigem reasoning complexo são direcionados para ChatGPT 5.0. Esta abordagem reduziu custos em 40% mantendo qualidade superior.

O challenge técnico principal está no desenvolvimento do classificador. Ele precisa ser extremamente rápido (adiciona latência mínima) mas suficientemente sofisticado para tomar decisões corretas. Utilizamos um modelo pequeno treinado especificamente para esta tarefa de routing.

Fallback strategies

Sistemas de produção necessitam robustez, e uma arquitetura híbrida permite implementar fallbacks inteligentes que garantem disponibilidade mesmo quando um dos providers está indisponível.

Primary-secondary cascading:

ChatGPT 5.0 como primary para quality-critical tasks

Llama 4.0 como fallback com prompts adaptados

Local lightweight model como último recurso

Load balancing inteligente:

Distribuição baseada em capacity e response times

Automatic failover com quality gates

Cost optimization através de provider selection

Case studies: Decisões em cenários reais

Aplicação de análise de contratos

Para uma aplicação que processa contratos legais, a decisão foi clara após testes comparativos. ChatGPT 5.0 demonstrou superior compreensão de linguagem jurídica complexa e nuances contratuais que modelos open-source não conseguiam capturar consistentemente.

O investimento adicional se justificou pela redução dramática em falsos positivos. Em contratos, um erro de interpretação pode ter consequências legais significativas, tornando a precisão mais importante que o custo operacional.

Sistema de customer support automatizado

Cenário completamente diferente emergiu ao desenvolver um sistema de customer support. Após análise de 10K+ tickets históricos, identificamos que 80% das queries seguem padrões previsíveis que podem ser tratados eficientemente por modelos menores.

A arquitetura implementada utiliza Llama 4.0 fine-tuned para as 80% de queries padrão, com escalation automático para ChatGPT 5.0 apenas para casos complexos ou ambíguos. Esta estratégia reduziu custos operacionais em 60% mantendo índices de satisfação altos.

Gerador de conteúdo multimodal

Para aplicações que combinam texto e imagens, a superioridade dos modelos OpenAI é mais evidente. A capacidade de processar contexto visual junto com instruções textuais ainda está significativamente à frente nos modelos comerciais.

Implementamos uma arquitetura onde a análise visual acontece via OpenAI, mas a geração de texto subsequente utiliza modelos open-source que recebem o contexto visual já processado. Esta divisão de responsabilidades otimiza tanto custo quanto performance.

Considerações de Implementation

Requisitos de Infraestrutura

A escolha tecnológica impacta dramaticamente os requisitos de infraestrutura e as competências necessárias na equipe técnica.

Integração com OpenAI:

Infraestrutura mínima de overhead

Foco na integração da API e manipulação de erros

Crescimento em escala acontece automaticamente

Deploy do modelo Open-source:

Investimento significativo em infraestrutura necessária

Recursos de GPU e conhecimento especializado necessários

Controle total sobre dimensionamento e otimização

Segurança e conformidade mais fáceis de implementar

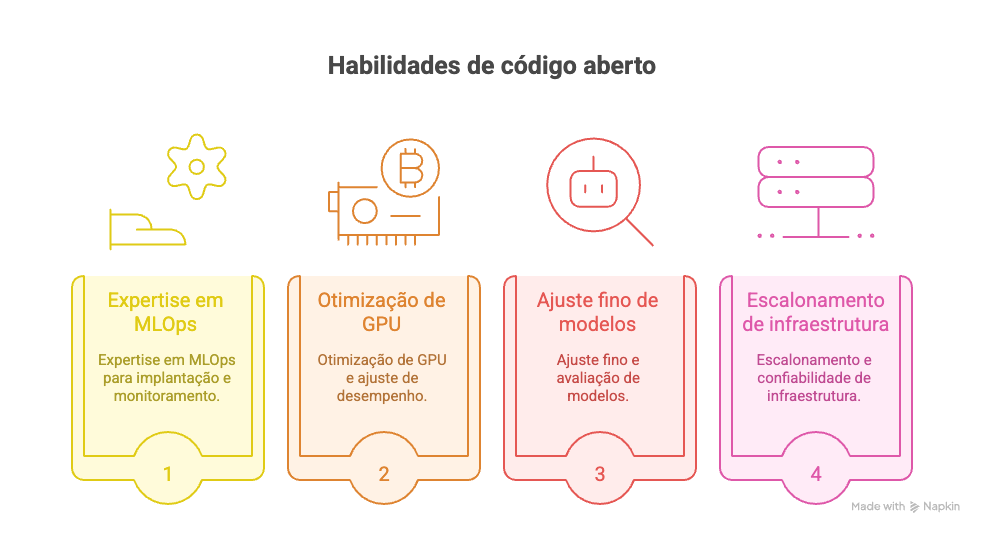

Avaliação das capacidades do Time

Antes de fazer qualquer decisão arquitetural, é fundamental avaliar transparentemente as capabilities da equipe técnica. Implementar e manter modelos open-source em produção exige expertise específica que nem todas as organizações possuem.

Habilidades necessárias para open-source:

Expertise em MLOps para implantação e monitoramento

Otimização de GPU e ajuste de desempenho

Ajuste fino e avaliação de modelos

Escalonamento e confiabilidade de infraestrutura

Implementação da OpenAI:

Melhores práticas de integração de API

Engenharia de prompt e otimização rápidas

Monitoramento e gerenciamento de custos

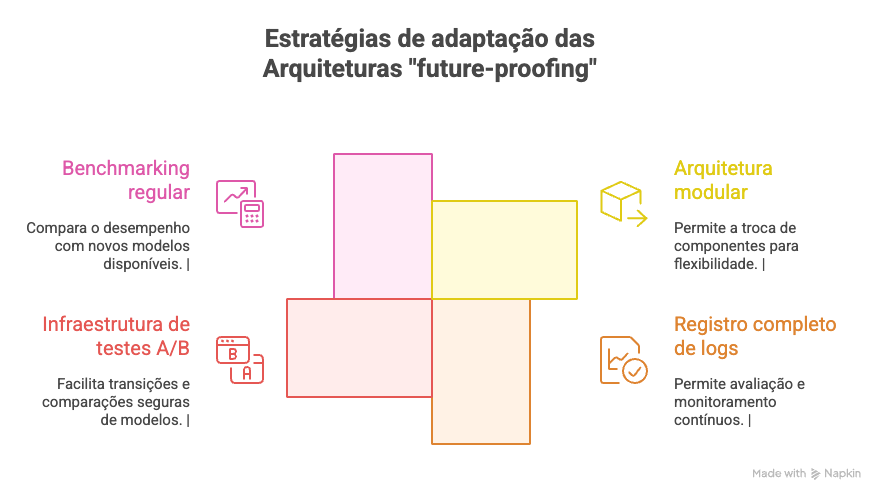

Estratégias à prova de futuro "Future-proofing"

Independência do Vendor

Uma consideração estratégica importante é evitar vendor lock-in excessivo. Mesmo ao utilizar primariamente a OpenAI, é sensato manter capacidades para migrações se necessário.

Isso envolve projetar abstrações que permitam a troca de modelos com relativa facilidade, manter prompts em formatos padronizados e manter conjuntos de dados de avaliação que permitam benchmarking de alternativas.

Planejamento das Evoluções

O panorama de IA evolui rapidamente, e decisões feitas hoje podem se tornar obsoletas em meses. Planejar para evolução significa o designing de sistemas que podem incorporar novos modelos e possuem capacidades expandidas sem grandes refatorações.

Estratégias de adaptação:

Arquitetura modular que permite a troca de componentes

Registro completo de logs para avaliação contínua

Infraestrutura de testes A/B para transições seguras de modelos

Benchmarking regular com novos modelos disponíveis

Conclusão: Pensamento estratégico em vez de escolhas táticas

A escolha entre OpenAI e modelos open-source não deve ser guiada por preferencias tecnológicas ou considerações de custos por si só. É uma decisão estratégica que deve alinhada com objetivos do negócio, capacidades técnicas e visão de longo prazo.

O framework mais eficaz combina ambas as abordagens estrategicamente, alavancando os pontos fortes de cada um e ao mesmo tempo mitigando as suas respectivas fraquezas. Esta abordagem híbrida permite otimizar vários objetivos simultaneamente: eficiência de custos, qualidade de desempenho, requisitos de conformidade e flexibilidade futura.

Para os CTOs tomarem estas decisões: comece com uma compreensão clara de seus casos de uso específicos, avalie honestamente as capacidades de sua equipe e projete a arquitetura que pode evoluir. A melhor solução, infelizmente, é puramente uma tecnologia ou outra, mas uma combinação bem pensada que atende às suas necessidades comerciais exclusivas.

No próximo artigo da série, exploraremos RAG (Retrieval Augmented Generation) para knowledge bases corporativas, mostrando como implementar sistemas que combinam informação proprietária com capacidades de reasoning avançadas.

Artigo originalmente publicado em www.guilhermefavaron.com.br