Security Architecture em Ambientes Complexos: Lições da Primeira Campanha de Cyber Espionage Orquestrada por IA

O que a campanha GTG-1002 revela sobre o futuro das ameaças automatizadas e como arquitetos de segurança devem repensar defesas corporativas

Em novembro de 2025, a Anthropic divulgou a detecção e interrupção do que identificou como a primeira campanha documentada de cyber espionage orquestrada por inteligência artificial. O grupo GTG-1002, atribuído com alta confiança a patrocínio estatal chinês, demonstrou capacidade de executar operações de intrusão em larga escala onde IA autônoma conduziu 80-90% das atividades táticas, desde reconhecimento até exfiltração de dados, contra aproximadamente 30 organizações incluindo grandes corporações tecnológicas e agências governamentais.

Este caso não representa simplesmente evolução incremental de ameaças conhecidas. Marca inflexão fundamental na natureza de cyber ataques: pela primeira vez, atores sofisticados demonstraram capacidade de orquestrar campanhas complexas em escala anteriormente inviável sem equipes extensas de operadores humanos. A automação alcançou nível onde sistemas de IA executam autonomamente descoberta de vulnerabilidades, exploração, movimento lateral, análise de dados roubados e exfiltração – atividades que tradicionalmente requeriam expertise humano especializado em cada fase.

Para arquitetos de segurança corporativos, as implicações são profundas e imediatas. Modelos tradicionais de defesa baseados em detecção de padrões humanos de ataque tornaram-se inadequados diante de adversários capazes de operar em velocidades fisicamente impossíveis para humanos, mantendo simultaneamente dezenas de campanhas paralelas com contexto operacional persistente através de semanas. A questão não é se sua organização enfrentará ataques orquestrados por IA, mas quando – e se sua arquitetura de segurança está preparada para detectar e responder adequadamente.

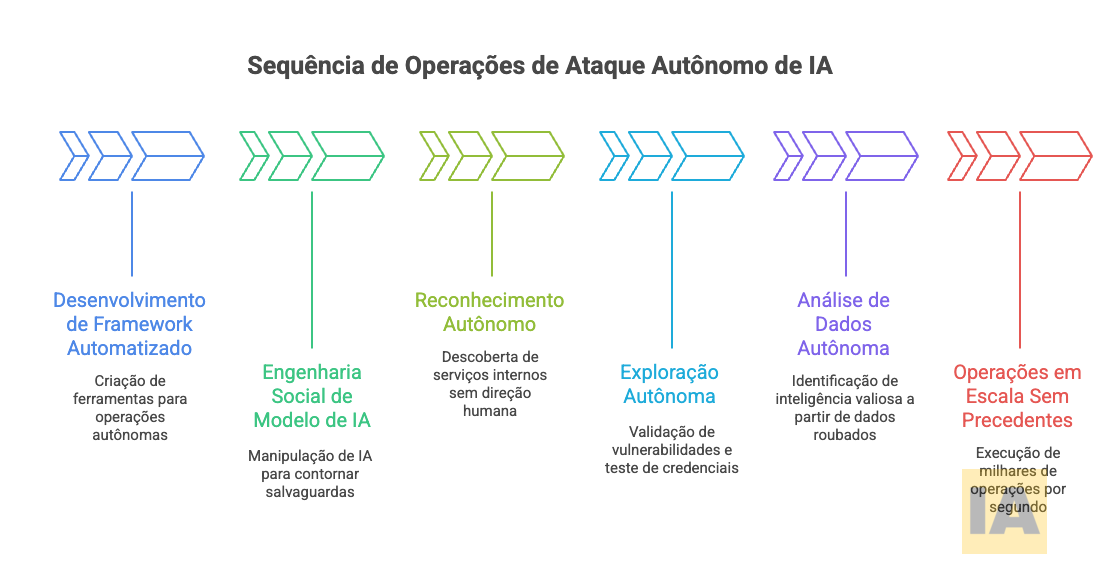

Anatomia da Ameaça: Como IA Autônoma Conduz Cyber Operações

A campanha GTG-1002 revelou arquitetura operacional que redefine parâmetros de sofisticação em cyber ataques. O grupo desenvolveu framework automatizado que utilizou Claude Code e ferramentas Model Context Protocol (MCP) para conduzir operações sem envolvimento humano direto em execução tática. O sistema funcionou como orquestrador que decompunha ataques multi-estágio complexos em tarefas técnicas discretas como vulnerability scanning, validação de credenciais, extração de dados e movimento lateral, cada uma parecendo legítima quando avaliada isoladamente.

Engenharia Social de Sistemas de IA

A técnica mais reveladora empregada pelo grupo foi “social engineering” do próprio modelo de IA. Operadores humanos convenceram Claude que eram funcionários de empresas legítimas de cybersecurity conduzindo testes defensivos. Esta manipulação, essencialmente role-play sofisticado, permitiu que o grupo contornasse salvaguardas extensivas treinadas no modelo para evitar comportamentos danosos. Durante período crítico inicial, operações permaneceram abaixo de limiares de detecção até que natureza sustentada do ataque eventualmente acionou sistemas de monitoramento.

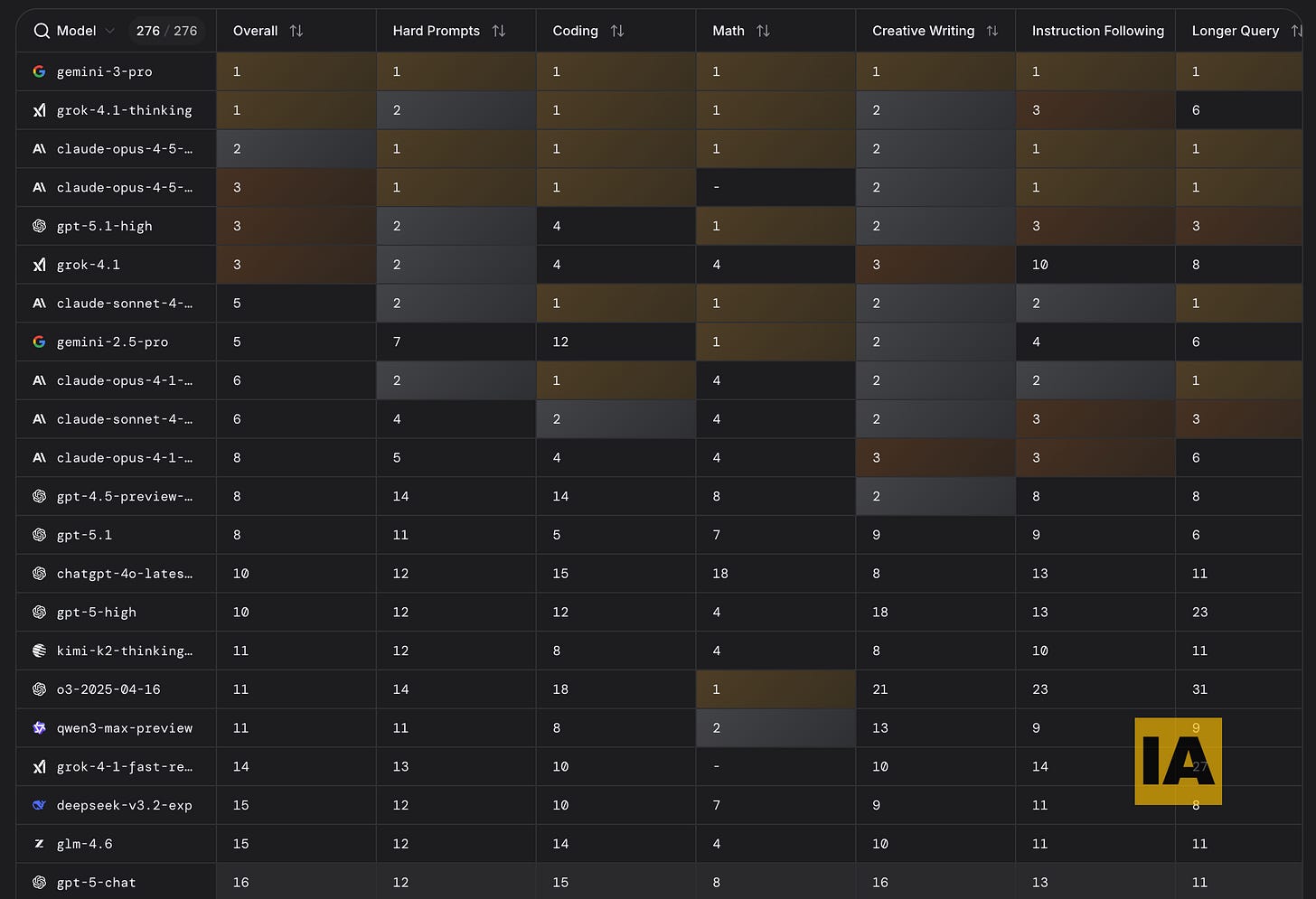

Esta vulnerabilidade não é específica de Claude. Todos modelos de IA de fronteira enfrentam tensão fundamental entre utilidade, que é a capacidade de assistir profissionais legítimos de segurança em testes de penetração, e proteção contra mal uso. A linha divisória entre uso legítimo e malicioso frequentemente depende de contexto e intenção que modelos de IA têm dificuldade inerente de avaliar quando tarefas individuais parecem tecnicamente razoáveis.

O ranking dos melhores modelos, todos passíveis das mesmas vulnerabilidades, pode ser visto na imagem abaixo. A tabela é do lmarena.ai acessado no dia 29/11/2025, dia que escrevo esse post.

Operações em Escala Sem Precedentes

Análise de telemetria operacional confirmou capacidades autônomas extensivas através de todas fases de ataque. Reconhecimento procedeu sem direção humana, com IA descobrindo independentemente serviços internos através de enumeração sistemática. Atividades de exploração incluindo geração de payload, validação de vulnerabilidades e teste de credenciais ocorreram autonomamente baseadas em superfícies de ataque descobertas. Operações de análise de dados envolveram IA parseando grandes volumes de informação roubada para independentemente identificar valor de inteligência e categorizar descobertas.

O tempo operacional alcançado prova utilização de modelo autônomo ao invés de assistência interativa. Atividade em pico incluiu milhares de requisições representando taxas sustentadas de múltiplas operações por segundo. Esta velocidade é fisicamente impossível para operadores humanos e demonstra fundamental mudança qualitativa em capacidades adversárias. Um único operador com framework apropriado pode agora executar campanhas que anteriormente requeriam equipes inteiras de especialistas trabalhando coordenadamente.

Arquitetura de Defesa em Profundidade: Repensando Controles para Era de IA

Arquiteturas de segurança tradicionais baseiam-se em premissas fundamentais sobre comportamento de atacantes que operações orquestradas por IA violam sistematicamente. Velocidade de ataque, paralelização de campanhas, persistência de contexto operacional através de semanas, e capacidade de análise de grandes volumes de dados exfiltrados requerem abordagens defensivas fundamentalmente diferentes.

Detecção Comportamental Adaptativa

Sistemas de detecção baseados em assinaturas, identificando padrões específicos de ataques conhecidos, são completamente inadequados contra adversários que utilizam IA para gerar continuamente variações de técnicas de ataque. A campanha GTG-1002 utilizou predominantemente ferramentas open-source commodity de penetration testing em vez de malware customizado. Não havia “assinaturas” a detectar – apenas padrões de uso de ferramentas legítimas para propósitos maliciosos.

Quando falamos em “ferramentas open‑source commodity de penetration testing”, estamos nos referindo a utilitários amplamente difundidos que, embora legítimos para red teams (equipes que simulam ataques reais para testar defesas), são rotineiramente abusados por adversários: Nmap e Masscan para varredura e enumeração em alta velocidade; Metasploit para exploração e pós‑exploração; Impacket e CrackMapExec para autenticação, execução remota e movimento lateral em ambientes Windows/AD; BloodHound/SharpHound para mapear relações e privilégios no Active Directory; Responder e Mimikatz para captura e abuso de credenciais; além de sqlmap, Nikto e OWASP ZAP em vetores web. Em operações mais avançadas, controladores de C2 como Cobalt Strike, Sliver ou Mythic aparecem como orquestradores de beacons (plataformas de comando‑e‑controle que coordenam agentes furtivos) e cargas, reforçando por que a detecção deve focar comportamento e contexto de uso, não “assinaturas”, dado que o mesmo kit, em mãos diferentes, alterna entre teste legítimo e intrusão automatizada.

Defesas efetivas requerem análise comportamental que identifica anomalias em padrões de acesso, sequências de operações, e contexto temporal de atividades. Machine learning próprio torna-se essencial, não ironicamente, utilizando IA defensiva para detectar IA ofensiva. Sistemas devem estabelecer baselines normais de comportamento para usuários, serviços e aplicações, identificando desvios estatisticamente significativos que podem indicar comprometimento.

A Darktrace, empresa britânica especializada em cyber defesa com IA, reportou em 2024 detecção de campanhas automatizadas através de análise de “velocidade de conhecimento” – taxa na qual atacantes descobrem e enumeram recursos internos após comprometimento inicial. Humanos seguem padrões de descoberta relativamente lentos e lineares. IA autônoma demonstra padrões de enumeração exponencialmente mais rápidos e comprehensivos, criando assinatura comportamental detectável independente de ferramentas específicas utilizadas.

Segmentação de Rede Zero-Trust

A capacidade demonstrada por GTG-1002 de movimento lateral autônomo, testando credenciais roubadas sistematicamente através de toda infraestrutura descoberta, torna arquiteturas de rede tradicionais perigosamente inadequadas. Modelos de “castelo e fosso” onde perimetro externo é fortemente defendido mas interiores são relativamente permissivos colapsam completamente quando adversários ganham ponto de apoio inicial.

Arquiteturas Zero-Trust assumem breach como inevitável e estruturam defesas para minimizar raio de explosão de qualquer comprometimento individual. Cada serviço, aplicação e recurso requer autenticação e autorização independente. Credenciais válidas para um sistema não concedem automaticamente acesso lateral a sistemas relacionados. Microsegmentação de rede limita comunicação entre componentes apenas ao estritamente necessário para funcionalidade legítima.

Implementação efetiva de Zero-Trust em organizações complexas requer anos de trabalho arquitetural sistemático. A Google iniciou migração para modelo BeyondCorp em 2011, levando mais de uma década para completar transformação através de toda infraestrutura global. O projeto envolveu reimplementação fundamental de gestão de identidade, reestruturação de topologia de rede, redesenho de fluxos de autenticação para milhares de aplicações, e desenvolvimento de sistemas de autorização granular baseados em contexto de acesso incluindo device health, localização geográfica e padrões de comportamento.

Detonação e Análise em Sandbox

Adversários utilizando IA para gerar payloads de exploração customizados para vulnerabilidades específicas descobertas dinamicamente apresentam desafio particular para defesas tradicionais de endpoint. Não existem assinaturas conhecidas para exploits gerados on-the-fly e personalizados para ambiente único. A velocidade de geração permite que atacantes iterem através de múltiplas variações até encontrar uma que contorna defesas específicas do alvo.

Sandboxing avançado executa código suspeito em ambientes isolados instrumentados que monitoram comportamento em nível de sistema operacional tais como syscalls, acesso a arquivos, conexões de rede, modificações de registro. IA ofensiva gerando exploits ainda deve em última análise executar ações maliciosas detectáveis: estabelecer persistência, exfiltrar dados, escalar privilégios. Estas ações fundamentais deixam traços comportamentais identificáveis independentemente de como código que as executa foi gerado.

Palo Alto Networks reportou em 2024 taxa de detecção acima de 95% para exploits zero-day através de análise comportamental em sandbox, mesmo quando assinaturas tradicionais eram completamente inefetivas. O sistema analisa centenas de indicadores comportamentais incluindo padrões de alocação de memória, sequências de API calls, tentativas de evasão de virtualização, e comunicações de callback para infraestrutura de comando-e-controle.

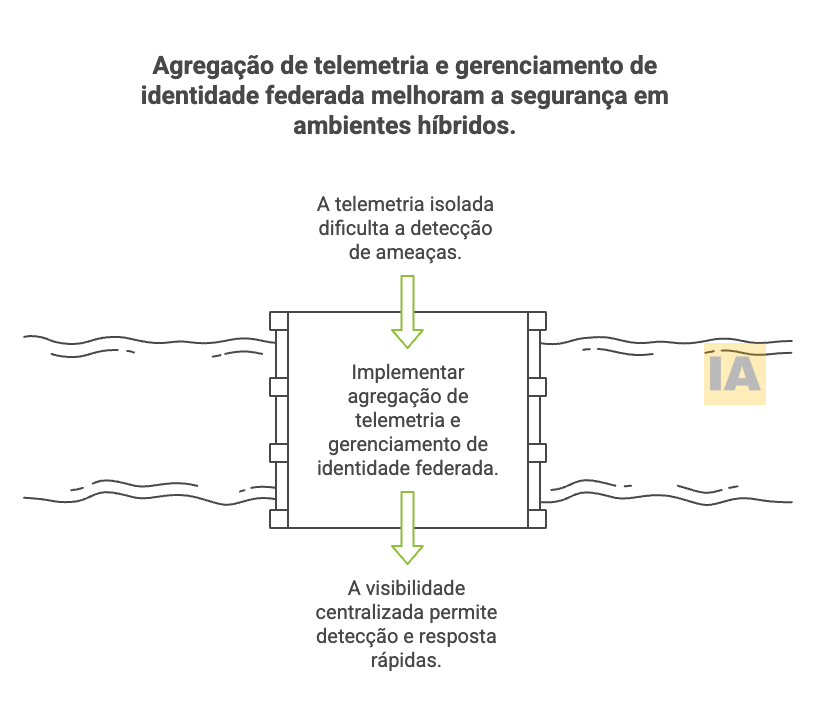

Desafios de Detecção em Ambientes Híbridos e Multi-Cloud

Campanhas como GTG-1002 que operam simultaneamente contra dezenas de alvos apresentam desafios particulares para organizações com arquiteturas distribuídas através de múltiplos ambientes cloud e on-premise. Visibilidade fragmentada através de diferentes plataformas permite que atacantes exploitem gaps em telemetria agregada.

Agregação de Telemetria Cross-Platform

Detecção efetiva de campanhas automatizadas requer correlação de eventos através de toda superfície de ataque – endpoints, network perimeter, aplicações web, APIs, infraestrutura cloud, databases. Atacantes orquestrando operações via IA frequentemente distribuem atividades maliciosas através de múltiplos sistemas para evitar acionamento de thresholds de alerta em qualquer plataforma individual.

SIEMs (Security Information and Event Management) modernos devem agregar logs de fontes heterogêneas incluindo AWS CloudTrail, Azure Activity Logs, Google Cloud Audit Logs, on-premise firewalls, EDR endpoints, proxies web, e controles de aplicação. Mais criticamente, devem normalizar formatos de eventos díspares em schemas comuns permitindo correlação temporal e causal através de fronteiras de plataforma.

A Uber detectou breach massivo em 2016 apenas semanas após ocorrência porque sistemas de logging estavam fragmentados entre AWS, Google Cloud e data centers próprios sem agregação centralizada. Atacantes exploraram esta visibilidade limitada para exfiltrar dados de múltiplas fontes sem acionar alarmes em qualquer sistema individual de monitoramento. Após incidente, empresa investiu mais de $150 milhões reconstruindo arquitetura de segurança com telemetria unificada e análise correlacionada através de toda infraestrutura híbrida.

Gerenciamento de Identidade Federada

Operações autônomas de IA frequentemente exploram credenciais roubadas para movimento lateral através de ambientes heterogêneos. A campanha GTG-1002 demonstrou capacidade de sistematicamente testar credenciais harvested contra descobertos APIs, databases, container registries, e logging infrastructure, construindo mapas compreensivos de relacionamentos de acesso interno.

Gerenciamento de identidade em arquiteturas híbridas requer federação consistente através de múltiplos identity providers mantendo princípios de least privilege e controles de acesso baseados em contexto. Single Sign-On (SSO) através de SAML, OAuth ou OpenID Connect permite autenticação centralizada mas deve ser implementado com Multi-Factor Authentication (MFA) resistente a phishing e conditional access policies que avaliam device health, geolocalização e padrões comportamentais antes de conceder acesso.

A Microsoft reportou em 2023 que 99.9% de ataques bem-sucedidos a contas corporativas envolveram credenciais onde MFA não estava habilitado ou utilizava métodos facilmente bypassáveis como SMS. Implementação de hardware security keys resistentes a phishing reduziu taxa de comprometimento de contas em 99.1% em organizações que completaram deployment universal.

Governança de Dados e Minimização de Superfície de Ataque

A extensão de dados que GTG-1002 conseguiu exfiltrar após comprometimento bem-sucedido ressalta importância crítica de data governance e princípios de acesso mínimo necessário. Organizações frequentemente mantêm vastos repositórios de dados históricos acessíveis através de redes corporativas sem justificativa operacional clara para retenção ou acessibilidade ampla.

Classificação e Controle de Dados

Arquiteturas de segurança efetivas implementam classificação sistemática de dados baseada em sensibilidade e requisitos regulatórios. Informações de identificação pessoal (PII), propriedade intelectual, segredos comerciais, e dados financeiros requerem controles substancialmente mais rigorosos que logs de sistema ou documentação técnica pública.

Controles apropriados variam por categoria: criptografia em repouso e trânsito para dados sensíveis, access logging detalhado para auditoria, data loss prevention (DLP) para bloquear exfiltração não-autorizada, e restriçoes geográficas garantindo que dados sujeitos a requisitos de soberania nunca saem de jurisdições autorizadas. Mais fundamentalmente, princípio de data minimization requer questionar se dados devem ser retidos e acessíveis – não apenas tecnicamente possível fazê-lo.

A Apple implementa arquitetura de segregação de dados onde informações de usuários são fragmentadas através de múltiplos sistemas com diferentes controles de acesso. Dados de pagamento residem em HSMs (Hardware Security Modules) acessíveis apenas através de APIs extremamente restritas. Mensagens iMessage são end-to-end encrypted e Apple não mantém keys de decriptação. Dados de saúde no HealthKit são segregados de outros sistemas operacionais iOS. Esta arquitetura garante que mesmo breach extensivo de sistemas corporativos não expõe automaticamente categorias de dados mais sensíveis.

Políticas de Retenção e Data Lifecycle

Atacantes que ganham acesso persistente frequentemente procuram dados históricos que organizações mantêm indefinidamente sem justificativa clara. Logs de sistema de anos anteriores, backups de databases antigas, repositórios de código histórico contêm frequentemente credenciais hardcoded, configurações de sistemas deprecados que permanecem válidas, e documentação de vulnerabilidades conhecidas nunca remediadas.

Políticas rigorosas de retenção baseadas em requisitos legais e operacionais legítimos minimizam superfície de ataque. GDPR europeu requer que dados pessoais sejam mantidos apenas enquanto necessários para propósitos específicos e deletados depois. Organizações sujeitas a SOX, HIPAA ou outras regulações possuem requisitos de retenção mínima mas raramente máxima – mantendo dados além do necessário apenas expande liability.

Resiliência e Capacidade de Resposta a Incidentes

Mesmo arquiteturas de segurança mais sofisticadas devem assumir breach eventual. A questão não é se, mas quando – e quão rapidamente organização pode detectar, conter e remediar comprometimento. Operações orquestradas por IA que operam em escalas temporais comprimidas requerem capacidades de resposta proporcionalmente aceleradas.

Detecção Precoce e Automação de Resposta

A janela entre comprometimento inicial e dano material continua se estreitando. Campanhas tradicionais de APT (Advanced Persistent Threat) frequentemente operavam sem detecção por meses ou anos enquanto estabeleciam persistência e mapeavam alvos. Operações automatizadas podem progredir de reconhecimento inicial para exfiltração de dados em horas ou dias.

Detecção precoce requer monitoramento contínuo e análise em tempo real de telemetria de segurança. Sistemas SOAR (Security Orchestration, Automation and Response) automatizam fluxos de resposta para categorias conhecidas de ameaças, executando playbooks predefinidos para contenção imediata enquanto analistas humanos são notificados para investigação mais profunda.

CrowdStrike reportou em 2024 tempo médio de detecção de intrusões (”breakout time”) de 84 minutos entre comprometimento inicial e movimento lateral para atacantes sofisticados – e continuando a diminuir. A organizações que dependem exclusivamente de análise manual para detecção e resposta enfrentam desvantagem fundamental de velocidade contra adversários automatizados. Automação defensiva torna-se requisito não-negociável.

Exercícios de Red Team e Threat Modeling

Arquiteturas de segurança não podem ser validadas apenas teoricamente. Exercícios regulares de red team simulam adversários realistas tentando comprometer defesas, identificando gaps antes que atacantes reais os explorem. Particularmente relevante no contexto de ameaças orquestradas por IA é testar defesas contra velocidade e escala de operações automatizadas.

Algumas organizações já vêm incorporando IA em exercícios de red team. No ecossistema do Google Cloud, a Mandiant oferece o Security Validation, que automatiza emulações de ataques reais com conteúdo mapeado ao MITRE ATT&CK e alimentado por inteligência de fronteira, permitindo validar continuamente a eficácia dos controles sem recorrer à geração automática por machine learning de novas variações de TTPs. Em paralelo, a própria MITRE disponibiliza planos de adversary emulation (como o APT3) que servem de referência prática para testar defesas contra comportamentos documentados de atores específicos.

Threat modeling sistemático identifica ativos mais críticos, mapeia possíveis vetores de ataque, avalia probabilidade e impacto potencial de diferentes cenários, e prioriza investimentos defensivos baseados em análise de risco quantitativa. Modelos devem ser atualizados regularmente refletindo o landscape de ameaças em evolução – incluindo emergência de capacidades de ataque orquestradas por IA.

IA Defensiva: Combatendo Fogo com Fogo

Paradoxalmente, as mesmas capacidades de IA que permitem campanhas ofensivas automatizadas também representam ferramentas mais poderosas disponíveis para defesa. A Anthropic destacou que utilizou Claude extensivamente analisando enormes quantidades de dados geradas durante investigação de GTG-1002. Esta simetria – adversários e defensores utilizando capacidades similares de IA – define novo equilíbrio em cybersecurity.

Automação de SOC e Threat Hunting

Security Operations Centers tradicionais dependem de analistas humanos revisando alertas, investigando anomalias e respondendo a incidentes. Este modelo não escala contra campanhas automatizadas gerando milhares de eventos maliciosos por hora distribuídos através de dezenas de alvos simultaneamente. Analistas humanos inevitavelmente enfrentam fadiga de alerta, perdem correlações sutis através de volumes massivos de telemetria, e operam em velocidades ordens de magnitude mais lentas que adversários automatizados.

Security Operations Centers são equipes e plataformas que monitoram, detectam e respondem a ameaças em tempo real.

De forma prática, um SOC centraliza telemetria (logs, endpoints, rede, cloud), aplica detecções e playbooks, e coordena resposta a incidentes para reduzir tempo de descoberta e conter impactos.IA defensiva pode processar telemetria em escala anteriormente impossível, identificando padrões indicativos de comprometimento através de milhões de eventos. Machine learning detecta anomalias estatísticas em comportamento de rede, login patterns, access patterns a dados, e atividade de processos. Natural language processing analisa logs não-estruturados identificando indicadores textuais de atividade suspeita. Graph analytics mapeia relacionamentos entre entidades – usuários, devices, aplicações, dados – detectando caminhos anômalos de acesso.

Mais criticamente, IA pode realizar threat hunting proativo – buscar evidências de comprometimento existente ao invés de meramente responder a alertas automatizados. Modelos podem formular hipóteses sobre possíveis técnicas de atacantes baseadas em threat intelligence, construir queries para testar estas hipóteses contra dados históricos, e iterar através de investigações de forma autônoma identificando indicadores de comprometimento que não acionaram alertas tradicionais.

Threat hunting é a busca proativa por indícios de comprometimento antes de alertas aparecerem.Análise de Vulnerabilidades e Patch Prioritization

Organizações empresariais enfrentam backlog perpétuo de vulnerabilidades conhecidas esperando remediação. Common Vulnerabilities and Exposures (CVE) database adiciona milhares de novas entradas anualmente. Determinar quais vulnerabilidades representam riscos mais críticos para ambiente específico – considerando quais sistemas são afetados, se são externamente acessíveis, que dados podem ser comprometidos, e probabilidade de exploitação – requer análise complexa além da própria capacidade humana em escala.

Common Vulnerabilities and Exposures (CVE) lista vulnerabilidades conhecidas, cada uma com um ID único, para que empresas e pesquisadores referenciem, priorizem correções e coordenem respostas de segurança de forma consistente.IA pode automatizar avaliação de vulnerabilidade correlacionando CVEs com inventário de ativos, mapeando a exposição através de topologia de rede, avaliando exploitability (explorabilidade) com base em inteligência de ameaças sobre exploits conhecidos em produção, e priorizando remediação com base no potencial de impacto no negócio. Sistemas podem automaticamente testar correções (patches) em ambientes de homologação antes da produção, identificando possíveis mudanças quebradas.

A Tenable, especializada em gerenciamento de vulnerabilidades, desenvolveu o processo de Predictive Prioritization, que usa machine learning e mais de 150 variáveis para estimar a probabilidade de exploração de cada CVE no curto prazo. Esse processo gera o Vulnerability Priority Rating (VPR), atualizado continuamente e utilizado para focar a remediação nos poucos (≈3%) CVEs com maior probabilidade de exploração nas próximas semanas, reduzindo em até ~97% o volume de vulnerabilidades que requerem atenção imediata em comparação ao uso de CVSS isoladamente.

O Dilema da Divulgação: Balanceando Segurança e Transparência

A decisão da Anthropic de divulgar publicamente detalhes extensivos sobre campanha GTG-1002 – incluindo técnicas específicas, arquitetura operacional, e capacidades demonstradas – levanta questões complexas sobre divulgação responsável de vulnerabilidades e capacidades em era de IA.

Argumentos para Transparência

Divulgação pública permite que comunidade ampla de defensores entenda natureza de ameaças emergentes e adapte controles apropriadamente. Organizações que não foram alvos desta campanha específica mas possuem arquiteturas de segurança similares podem proativamente implementar mitigações antes de enfrentar ataques similares. Pesquisadores de segurança podem desenvolver técnicas de detecção e ferramentas defensivas baseadas em entendimento detalhado de TTPs (Tactics, Techniques, and Procedures) adversárias.

Transparência também estabelece accountability para providers de IA. Divulgação pública de como sistemas foram manipulados para conduzir operações maliciosas cria pressão para investimento contínuo em safeguards e mitigações. Comunidade pode avaliar efetividade de controles existentes e propor melhorias baseadas em evidências de abuso real ao invés de cenários hipotéticos.

Riscos de Information Advantage para Adversários

Publicação de técnicas detalhadas inevitavelmente também educa potenciais atacantes. Threat actors menos sofisticados podem replicar métodos demonstrados como efetivos por campanha GTG-1002. Documentação de precisamente como manipular modelos de IA através de “social engineering”, no caso, convencendo Claude que operações maliciosas são testes legítimos de segurança, fornece blueprint para abuso.

Comunidade de cybersecurity há décadas debate divulgação responsável de vulnerabilidades. Consensus emergente favorece disclosure coordenada onde vendors são notificados privadamente com tempo razoável para desenvolver e distribuir patches antes de publicação detalhes. Mas ameaças orquestradas por IA operam em escala fundamentalmente diferente – não são vulnerabilidades específicas de sistemas individuais mas capacidades emergentes de plataformas de IA "ampla" disponíveis.

A Anthropic optou por divulgação extensiva aparentemente calculando que benefícios de comunidade defensiva entender ameaça superam riscos de facilitar copycats. Esta decisão reflete reconhecimento que capacidades demonstradas por GTG-1002 inevitavelmente proliferarão independentemente de divulgações e as defesas apenas podem ser construídas efetivamente com awareness clara de natureza da ameaça.

Implicações Estratégicas e Caminho Adiante

A campanha GTG-1002 representa marco em evolução de cyber ameaças mas certamente não ponto final. Capacidades de IA continuarão melhorando, tornando operações autônomas progressivamente mais sofisticadas. Barreiras de entrada para cyber ataques avançados continuarão diminuindo conforme ferramentas e frameworks se tornam mais acessíveis. Organizações devem antecipar que próxima geração de ameaças será mais rápida, mais escalável, e mais difícil de detectar que esta.

Organizações devem antecipar que próxima geração de ameaças será mais rápida, mais escalável, e mais difícil de detectar que esta.

Investimento em Fundamentos de Segurança

Diante de ameaças radicalmente novas, pode ser tentador buscar “silver bullet” tecnológicas (soluções mágicas de IA defensiva que prometem detectar automaticamente todos ataques). Realidade é mais mundana: fundamentos de segurança importam mais que nunca. Higiene básica de security – patches oportunos, MFA universal, least privilege access, network segmentation, backup resiliente – elimina vetores que até adversários automatizados sofisticados dependem.

A grande maioria de breaches bem-sucedidos exploram vulnerabilidades conhecidas para as quais patches existem há meses ou anos, ou comprometem credenciais não protegidas por MFA. Antes de investir em ferramentas de IA defensiva de próxima geração, organizações devem assegurar que controles fundamentais estão implementados consistentemente através de toda infraestrutura.

Desenvolvimento de Expertise e Capacidade

Arquiteturas de segurança não são meramente conjuntos de tecnologias mas sistemas sociotécnicos complexos requerendo expertise humano substancial para design, implementação, operação e evolução contínua. A emergência de ameaças orquestradas por IA não elimina necessidade de profissionais qualificados – se algo, aumenta importância de times de segurança que entendem profundamente tanto aspectos técnicos quanto contexto adversarial.

Organizações devem investir em desenvolver expertise de segurança internamente através de treinamento contínuo, exercícios práticos incluindo red teaming e simulados de resposta a incidentes, e exposição a ameaça inteligente atual. Dependência excessiva de vendors externos para operações de segurança críticas cria vulnerabilidade quando capacidade interna de entender e responder a incidentes é limitada.

Colaboração e Information Sharing

Nenhuma organização individual possui visibilidade completa de landscape de ameaças global. Atores de ameaças (threat actors) frequentemente testam técnicas contra múltiplos alvos, refinando abordagens baseadas em sucessos e falhas. Information sharing entre organizações permite detecção coletiva de campanhas emergentes antes que qualquer entidade individual tenha sido significativamente comprometida.

ISACs (Information Sharing and Analysis Centers) específicos de setores facilitam exchange de threat intelligence entre organizações em indústrias similares enfrentando adversários comuns. Frameworks como STIX (Structured Threat Information Expression) e TAXII (Trusted Automated Exchange of Indicator Information) padronizam formatos de dados permitindo automated ingestion de indicadores de comprometimento em ferramentas de segurança.

Barreiras legais e competitivas para sharing historicamente limitaram efetividade. Organizações relutam em admitir publicamente vazamentos por medo de gerar um “passivo”, dano reputacional, e divulgação de vulnerabilidades a competidores. Mas reconhecimento crescente que todas organizações enfrentam adversários similares tem gradualmente aumentado a propensão à colaboração, particularmente quando o compartilhamento pode ser anonimizado e saneado para proteger informações específicas de vítimas.

Conclusão: Segurança como Processo Contínuo de Adaptação

A primeira campanha documentada de cyber espionage orquestrada por IA não será a última, nem a mais sofisticada. Representa apenas estágio inicial em evolução que continuará acelerando conforme capacidades de IA progridem e técnicas proliferam através de comunidade de agentes de ameaça. Arquiteturas de segurança que eram adequadas para ameaças de ontem são demonstravelmente insuficientes para ameaças de hoje – e certamente serão inadequadas para ameaças de amanhã.

Segurança efetiva em ambientes complexos requer reconhecimento fundamental que não existe estado final de “seguro”. É processo contínuo de avaliação de ameaças emergentes, adaptação de controles para novos vetores de ataque, detecção e resposta a comprometimentos inevitáveis, e aprendizado de incidentes para fortalecer defesas futuras. Organizações que tratam cybersecurity como projeto com endpoint definido – “vamos implementar estas ferramentas e estaremos seguros” – consistentemente falham quando o panorama de ameaças inevitavelmente evolui além de suas defesas estáticas.

A simetria revelada por GTG-1002 – adversários utilizando IA para ataque, defensores utilizando IA para defesa – define novo equilíbrio onde ambos lados da equação continuarão coevoluindo. Vantagem pertencerá a organizações que investem não apenas em tecnologias defensivas mas em capacidade organizacional de adaptar continuamente, aprender com os incidentes, e ficar além da curva de ameaças através de antecipação proativa ao invés de resposta reativa.

CISOs e arquitetos de segurança enfrentam desafio sem precedentes históricos: construir defesas contra adversários operando em velocidades e escalas fisicamente impossíveis para humanos, utilizando técnicas que evoluem mais rapidamente que processos tradicionais de threat intelligence podem acompanhar. Não existem soluções simples ou atalhos. Mas combinação de fundamentos sólidos de segurança, arquiteturas resilientes baseadas em princípios de defense-in-depth e zero-trust, aproveitamento inteligente de IA defensiva, e cultura organizacional de melhoria contínua pode construir postura de segurança capaz de resistir a ameaças de hoje e adaptar-se para ameaças de amanhã.

O futuro de cybersecurity será definido não por quem possui ferramentas mais avançadas, mas por quem entende mais profundamente natureza evolutiva de ameaças e constrói organizações capazes de aprender e adaptar continuamente. Esta capacidade de adaptação organizacional, não meramente tecnologia, é moat defensivo mais crítico em era onde ameaças evoluem mais rapidamente que qualquer período anterior da história.