Estratégias de Migração para Cloud: Navegando Entre Public, Private e Hybrid

Quando a Capital One anunciou em 2020 que concluiria sua migração completa para AWS até o final daquele ano, a decisão representou mais que uma mudança tecnológica: foi uma aposta de $150 milhões em transformação digital que prometia reduzir custos operacionais em 30% e acelerar time-to-market de novos produtos em até 50%. A instituição financeira eliminou seus últimos data centers proprietários, consolidando toda infraestrutura crítica na nuvem pública.

No mesmo período, o Walmart seguia caminho diametralmente oposto. A maior varejista do mundo investiu bilhões construindo uma das maiores infraestruturas de cloud privada do varejo global, recusando-se deliberadamente a utilizar AWS – propriedade de seu maior concorrente, a Amazon. O gigante do varejo argumentava que independência tecnológica, proteção de dados proprietários de logística e supply chain, e controle total sobre performance durante picos críticos como Black Friday justificavam manter infraestrutura própria para workloads estratégicos.

Ambas as organizações são líderes em seus mercados. Ambas possuem arquiteturas sofisticadas. Ambas tomaram decisões racionais baseadas em suas realidades específicas. E ambas nos ensinam algo fundamental: não existe uma “estratégia correta” de migração para cloud, apenas escolhas apropriadas para contextos específicos.

O Espectro de Modelos de Cloud: Além da Dicotomia Simplista

A discussão sobre cloud computing frequentemente se reduz a uma falsa dicotomia entre “tudo ou nada” – migrar completamente para cloud pública ou manter tudo on-premise. A realidade das arquiteturas empresariais modernas é significativamente mais nuançada, operando em um espectro contínuo de possibilidades que combinam diferentes modelos conforme necessidades específicas.

As organizações podem escolher entre cinco abordagens arquiteturais principais, cada uma com implicações distintas para governança, custos operacionais e capacidade de inovação:

Public Cloud representa a utilização de infraestrutura compartilhada gerenciada por provedores como AWS, Azure ou Google Cloud. Este modelo oferece elasticidade quase infinita e economia de escala, eliminando necessidade de investimento inicial em hardware. Empresas como Netflix processam bilhões de streaming requests diariamente nesta arquitetura, demonstrando viabilidade mesmo para cargas críticas de missão.

Private Cloud mantém infraestrutura dedicada, seja on-premise ou em data centers terceirizados. O Walmart construiu uma das maiores infraestruturas de cloud privada do varejo, processando milhões de transações diárias e gerenciando logística global sem depender de AWS – propriedade de seu principal concorrente. Esta decisão estratégica, embora signifique custo total de propriedade significativamente superior, garante independência competitiva, proteção de propriedade intelectual em supply chain optimization e controle absoluto sobre performance durante eventos críticos como Black Friday, quando bilhões de dólares dependem de uptime perfeito.

Hybrid Cloud integra ambientes públicos e privados através de orquestração centralizada, permitindo que workloads migrem entre infraestruturas conforme demanda. A BMW utiliza esta abordagem para manter dados sensíveis de design em cloud privada enquanto executa simulações computacionalmente intensivas em cloud pública, otimizando custos sem comprometer propriedade intelectual.

Multi-cloud distribui workloads entre múltiplos provedores públicos, reduzindo dependência excessiva de um único vendor. No caso do Spotify, a estratégia combina AWS e Google Cloud: a AWS sustenta o armazenamento e a entrega de mídia em escala global (objetos em S3, replicação multi-região, CDN/edge para baixa latência e alta disponibilidade), enquanto o Google Cloud orquestra os pipelines e a infraestrutura de dados (BigQuery, Pub/Sub e Dataflow) para analytics, personalização e machine learning. Assim, a empresa mitiga riscos de vendor lock-in e aproveita capacidades específicas de cada plataforma — ML e análise avançada no GCP, com distribuição confiável de conteúdo e escala operacional na AWS.

Edge Computing complementa estratégias cloud processando dados próximo à origem, reduzindo latência para aplicações críticas. Redes 5G e IoT industrial dependem desta arquitetura para garantir tempos de resposta sub-milissegundo que cloud centralizada não consegue alcançar.

A escolha entre estes modelos raramente é binária. Arquiteturas empresariais maduras frequentemente combinam múltiplas abordagens, criando topologias complexas onde diferentes workloads residem em ambientes otimizados para seus requisitos específicos.

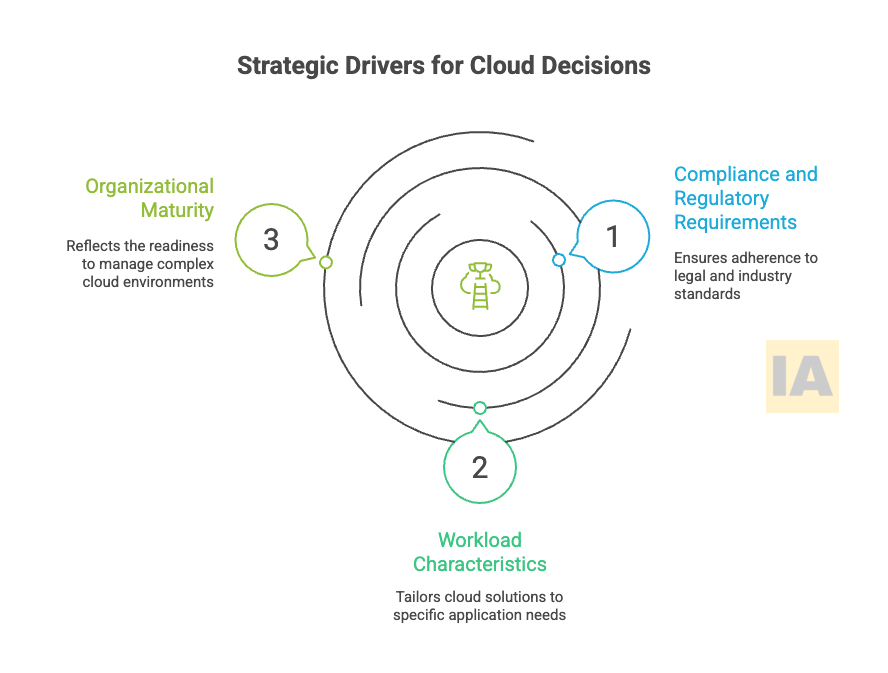

Drivers Estratégicos: O Que Realmente Importa na Decisão

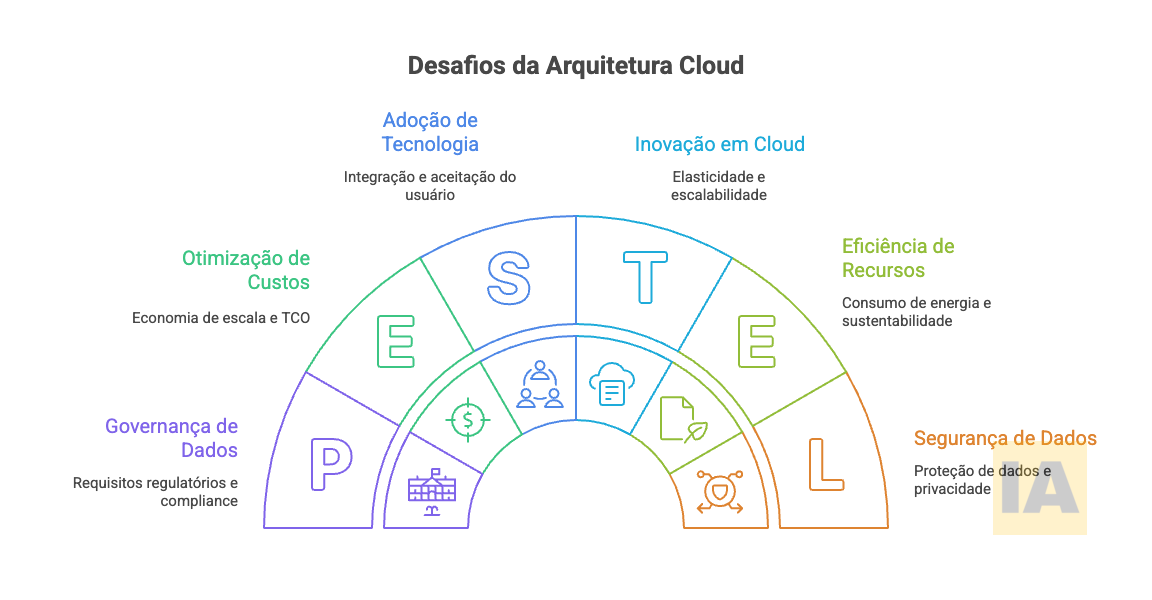

Decisões arquiteturais sobre cloud não devem ser guiadas por hype tecnológico ou preferências pessoais de equipes técnicas. Três dimensões fundamentais determinam qual estratégia é apropriada para cada contexto organizacional:

requisitos de compliance e soberania de dados,

perfil de workload e padrões de uso, e

capacidade organizacional para gestão de complexidade.

Compliance e Requisitos Regulatórios

Setores altamente regulados enfrentam restrições significativas sobre onde dados podem residir e quem pode acessá-los. Instituições financeiras europeias sujeitas a GDPR não podem simplesmente migrar dados de clientes para data centers em outras jurisdições sem garantias específicas de proteção. Healthcare providers nos Estados Unidos devem garantir HIPAA compliance, o que requer controles rigorosos sobre acesso e auditoria.

Estas restrições não necessariamente eliminam cloud pública como opção. AWS oferece regiões específicas na Europa com garantias contratuais de soberania de dados. Azure Government fornece ambientes isolados certificados para workloads governamentais sensíveis. O que é essencial é arquitetar soluções que satisfaçam requisitos regulatórios enquanto maximizam benefícios de cloud.

Características dos Workloads

Diferentes aplicações possuem perfis operacionais distintos que favorecem modelos específicos de cloud. Sistemas com demanda altamente variável – como e-commerce durante Black Friday ou processamento de folha de pagamento no fim do mês – beneficiam-se enormemente de elasticidade de cloud pública. A capacidade de escalar de 100 para 10.000 instâncias em minutos e retornar ao baseline depois é economicamente inviável em infraestrutura tradicional.

Por outro lado, workloads com utilização estável e previsível podem ser mais econômicos em infraestrutura dedicada. Um sistema ERP que processa consistentemente 5.000 transações por hora, 24/7, não se beneficia significativamente de elasticidade. O custo de instâncias reservadas ou infraestrutura própria pode ser inferior ao pay-as-you-go de cloud pública.

Latência é outro fator crítico. Aplicações financeiras de high-frequency trading operam em microsegundos – cada milissegundo de latência adicional representa milhões em oportunidades perdidas. Estas aplicações frequentemente requerem infraestrutura dedicada próxima às bolsas de valores, inviabilizando cloud pública centralizada.

Maturidade Organizacional

Arquiteturas híbridas e multi-cloud introduzem complexidade operacional substancial. Gerenciar workloads distribuídos entre múltiplos ambientes requer expertise em orquestração, networking avançado, identity management federado e observabilidade em sistemas distribuídos. Organizações sem estas capacidades podem descobrir que custos operacionais de arquiteturas complexas superam benefícios teóricos.

A Capital One investiu anos desenvolvendo cultura DevOps e automação antes de migrar completamente para AWS. Não foi simplesmente uma questão de “mover servidores” – foi transformação organizacional profunda que incluiu retraining de milhares de engenheiros, redesenho de processos de desenvolvimento e implementação de práticas modernas de engenharia de confiabilidade.

Considerações Competitivas e Estratégicas

Além de compliance, fatores competitivos podem determinar escolhas arquiteturais. O Walmart exemplifica esta dinâmica: sendo o maior concorrente da Amazon no varejo, a empresa decidiu que pagar ao rival para hospedar dados proprietários de supply chain, algoritmos de pricing e inteligência de consumer behavior representava risco estratégico inaceitável. A decisão de construir infraestrutura privada custou bilhões adicionais comparado a utilizar AWS, mas garantiu que dados críticos de negócio nunca residiriam em sistemas controlados pelo competidor principal.

Esta lógica não se limita ao varejo. Qualquer organização competindo diretamente com cloud providers ou seus parent companies deve avaliar cuidadosamente implicações de longo prazo de deep vendor dependency. A questão não é paranoia e sim due diligence estratégica sobre onde dados mais valiosos residem e quem possui acesso potencial a eles.

Padrões de Migração: Do Lift-and-Shift ao Cloud-Native

Após definir qual modelo de cloud é apropriado, organizações enfrentam decisão igualmente crítica: como migrar aplicações existentes? A indústria convergiu em torno de seis padrões principais de migração, conhecidos como “6 Rs” – Rehost, Replatform, Repurchase, Refactor, Retire e Retain. Cada abordagem possui trade-offs distintos entre velocidade de execução, investimento necessário e benefícios realizados.

Rehost (Lift-and-Shift) move aplicações para cloud sem modificações arquiteturais significativas. Virtual Machines (VMs) on-premise são replicadas como instâncias EC2 ou Azure VMs, mantendo configurações e dependências existentes. Esta abordagem minimiza risco e permite migração rápida – organizações frequentemente movem centenas de aplicações em meses utilizando ferramentas automatizadas.

O trade-off é óbvio: aplicações migradas via lift-and-shift não se beneficiam de capacidades cloud-native. Elasticidade, managed services e arquiteturas serverless permanecem inacessíveis. Custos operacionais podem até aumentar se aplicações mal otimizadas simplesmente replicam ineficiências existentes em infraestrutura mais cara.

Replatform introduz otimizações menores durante migração. Um banco de dados on-premise pode migrar para RDS gerenciado, eliminando overhead de administração sem redesenhar aplicação. Web servers podem mover para load balancers gerenciados, containers podem substituir VMs individuais. Estas mudanças incrementais capturam alguns benefícios cloud enquanto minimizam reengenharia.

A Expedia Group utilizou extensivamente replatforming durante sua migração multi-ano para AWS. Sistemas críticos migraram para serviços gerenciados quando possível, reduzindo em 60% o tempo que equipes de infraestrutura gastavam com undifferentiated heavy lifting – manutenção de databases, patches de segurança, backups. Isto liberou recursos para inovação em funcionalidades que efetivamente diferenciam o negócio.

Refactor (Re-architect) redesenha aplicações para arquiteturas cloud-native. Monolitos são decompostos em microservices, bancos de dados relacionais migram para modelos NoSQL quando apropriado, batch processing torna-se event-driven através de message queues. Esta abordagem maximiza benefícios cloud mas requer investimento substancial e riscos de execução.

A Netflix é exemplo emblemático de refactoring bem-sucedido. A migração completa para AWS levou sete anos e envolveu reescrever fundamentalmente a arquitetura. O resultado é uma plataforma que escala dinamicamente para servir 200+ milhões de subscribers globalmente, sobrevive a falhas de infraestrutura através de chaos engineering e inova continuamente através de milhares de deploys diários.

Repurchase substitui aplicações customizadas por soluções SaaS. Sistemas de CRM migram para Salesforce; ERP on-premise é substituído por SAS cloud. Esta abordagem elimina necessidade de migração técnica mas introduz dependências de vendors e pode requerer mudanças significativas em processos de negócio.

Retire identifica aplicações que não agregam mais valor e podem ser simplesmente desligadas. Auditorias pré-migração frequentemente descobrem que 10-20% de aplicações corporativas são raramente utilizadas ou possuem funcionalidade duplicada. Eliminar estas aplicações reduz custos de migração e simplifica paisagem tecnológica.

Retain decide conscientemente manter certas aplicações on-premise, seja por requisitos regulatórios, limitações técnicas ou falta de justificativa econômica para migração. Esta é decisão estratégica válida que deve ser periodicamente reavaliada.

Arquitetando para Híbrido: Conectividade e Orquestração

Organizações que adotam estratégias híbridas ou multi-cloud enfrentam desafios arquiteturais complexos na integração de ambientes distintos. Dois pilares fundamentais sustentam arquiteturas híbridas bem-sucedidas: conectividade de rede robusta e de baixa latência entre ambientes, e camadas de abstração que permitem orquestração unificada de recursos distribuídos.

Conectividade e Networking

Arquiteturas híbridas fracassam ou prosperam com base na qualidade de conectividade entre ambientes. Internet pública raramente oferece bandwidth, latência ou confiabilidade necessários para workloads empresariais críticos. Organizações maduras implementam conectividade dedicada através de AWS Direct Connect, Azure ExpressRoute ou interconexões privadas em data centers de colocation.

A JPMorgan Chase opera uma das redes privadas mais extensas do setor financeiro, conectando data centers proprietários a múltiplos availability zones em AWS e Azure através de circuitos dedicados de 100Gbps. Esta infraestrutura permite que workloads migrem entre ambientes com latências sub-5ms, viabilizando casos de uso como disaster recovery ativo-ativo e bursting computacional para cloud durante picos de demanda.

Networking em arquiteturas híbridas requer planejamento cuidadoso de IP addressing, DNS federado, firewalls distribuídos e políticas de segmentação consistentes entre ambientes. Sobrepor endereços IP entre on-premise e cloud cria problemas insolúveis. Rotear tráfego entre ambientes sem visibilidade de segurança introduz vulnerabilidades. Ferramentas como HashiCorp Consul e service meshes como Istio ajudam gerenciar complexidade, mas requerem expertise especializado.

Orquestração e Abstração

Gerenciar workloads distribuídos manualmente entre clouds é operacionalmente inviável em escala. Arquiteturas híbridas maduras implementam camadas de abstração que permitem provisionamento, deployment e gestão unificados independente de onde recursos residem fisicamente.

Kubernetes emergiu como padrão de facto para orquestração de containers em ambientes híbridos. Clusters podem span múltiplos clouds e on-premise, com workloads sendo schedulados baseado em requisitos declarativos – latência, compliance, custo, afinidade com dados. Ferramentas como Anthos (Google), Azure Arc e AWS Outposts oferecem controles gerenciados que abstraem complexidade de múltiplos ambientes.

A Target Corporation utiliza Kubernetes para orquestrar milhares de microservices distribuídos entre data centers próprios e Google Cloud. Durante Black Friday, workloads de e-commerce automaticamente escalam para cloud quando capacidade on-premise satura, e retornam depois. Desenvolvedores não precisam conhecer onde código executa – apenas definem requisitos e plataforma decide placement ótimo.

Infrastructure-as-Code tornou-se requisito não-negociável para arquiteturas híbridas. Terraform, Pulumi e ferramentas similares permitem definir infraestrutura declarativamente, com mesmo código provisionando recursos em AWS, Azure, on-premise ou Google Cloud. Isto garante consistência, auditabilidade e capacidade de reproduzir ambientes deterministicamente.

Otimização de Custos: FinOps em Ambientes Híbridos

Cloud prometeu reduzir custos de infraestrutura através de economia de escala e utilização otimizada. A realidade frequentemente decepciona: estudos indicam que 30-35% de gastos cloud são desperdício – instâncias superdimensionadas, recursos não-utilizados, arquiteturas ineficientes. Em ambientes híbridos, desafios de otimização multiplicam-se exponencialmente.

Visibilidade e Atribuição

Organizações não podem otimizar o que não medem. Arquiteturas híbridas requerem agregação de custos de múltiplas fontes – cloud providers, data centers próprios, circuitos de rede, licenses de software. Modelos de costing diferem radicalmente: cloud cobra por utilização granular, on-premise possui custos fixos amortizados, licenses podem ser por core, por usuário ou por transação.

Implementar chargeback ou showback efetivo requer tagging consistente de recursos, mapeamento de custos de infraestrutura compartilhada, e alocação proporcional de overheads. Ferramentas de FinOps como CloudHealth, CloudCheckr ou Apptio Cloudability (IBM) agregam dados de múltiplas fontes e fornecem visibilidade unificada.

A Lyft implementou cultura de accountability de custos associando cada microservice a um cost center. Dashboards mostram em tempo real quanto cada time está gastando e tendências históricas. Quando custos de um serviço aumentam inesperadamente, alertas automáticos notificam donos antes que orçamentos sejam ultrapassados. Esta visibilidade reduziu desperdício em 25% no primeiro ano.

Otimização Arquitetural

Diferentes tipos de workload possuem perfis econômicos distintos em diferentes ambientes. Análises comparativas de TCO devem considerar não apenas custos de compute e storage, mas também data transfer, licenses, pessoal necessário para operação e oportunidades de receita perdidas por atrasos em time-to-market.

Workloads com demanda previsível e estável frequentemente são mais econômicos em instâncias reservadas ou infraestrutura dedicada. AWS Reserved Instances oferecem descontos de até 72% comparado a on-demand para compromissos de um ou três anos. Para workloads que executam continuamente, amortização supera flexibilidade de pay-as-you-go.

Spot instances e VMs preemptivas oferecem descontos de 60-90% para workloads tolerantes a interrupções. Rendering de vídeo, análises batch de dados, simulações científicas podem economizar substancialmente utilizando capacidade excedente. A Lyft processa bilhões de eventos analytics diariamente usando primariamente Spot instances, com fallback automático para on-demand quando disponibilidade é insuficiente.

Governança e Policy Enforcement

Arquiteturas híbridas sem governança apropriada rapidamente degeneram em shadow IT e proliferação descontrolada de recursos. Desenvolvedores provisionam instâncias que nunca são desligadas, storage cresce indefinidamente, ambientes de teste replicam configurações de produção desnecessariamente caras.

Implementar policies automatizadas previne desperdício na origem. Resources podem ser automaticamente taggeados com donos e data de expiração durante provisionamento. Workloads de desenvolvimento são automaticamente desligados após horário comercial e fins de semana e instâncias superdimensionadas geram alertas com recomendações de rightsizing.

Segurança e Compliance: Responsabilidade Compartilhada em Múltiplos Ambientes

Arquiteturas distribuídas entre múltiplos ambientes expandem superfície de ataque e fragmentam responsabilidades de segurança. O modelo de responsabilidade compartilhada na nuvem — em que o provedor é responsável pela segurança da infraestrutura e o cliente pela segurança das aplicações — torna-se significativamente mais complexo quando as cargas de trabalho se estendem por ambientes locais (on‑premises), múltiplas nuvens e borda (edge).

Identity e Access Management

Gerenciar identidades e permissões consistentemente através de ambientes heterogêneos é desafio crítico. Usuários precisam acessar aplicações independente de onde residem. Service accounts requerem permissões federadas para recursos distribuídos. Auditoria de acessos deve ser unificada apesar de múltiplos identity providers.

Federação de identidades através de SAML, OAuth ou OpenID Connect permite single sign-on entre ambientes. Active Directory on-premise pode federar com AWS IAM, Azure AD e Google Cloud IAM, permitindo que usuários utilizem credenciais corporativas existentes. Ferramentas como Okta, Ping Identity ou Azure AD fornecem identity brokering que abstrai diferenças entre providers.

Princípio de least privilege (mínimo privilégio) torna-se exponencialmente mais difícil em arquiteturas híbridas. Cada ambiente possui modelo de permissões próprio – IAM policies na AWS, role assignments no Azure, IAM roles no GCP. Garantir consistência requer frameworks de governança que definam policies abstratas traduzidas para implementações específicas de cada cloud.

Data Protection e Encryption

Dados transitando entre ambientes em arquiteturas híbridas devem ser protegidos tanto em trânsito quanto em repouso. Todas conexões entre on-premise e cloud devem utilizar encryption – IPSec VPNs, TLS/SSL para APIs, encryption-at-rest para storage. Keys de encriptação requerem gestão centralizada através de HSMs ou serviços gerenciados como AWS KMS, Azure Key Vault ou HashiCorp Vault.

Estratégias de data residency são críticas para compliance em setores regulados. Dados de clientes europeus podem residir apenas em regiões EU de cloud providers. Healthcare data nos EUA deve satisfazer HIPAA, frequentemente requerendo ambientes dedicados isolados de outros workloads. Arquiteturas híbridas devem implementar data classification e routing automático para garantir que dados sensíveis nunca saem de ambientes autorizados.

Resposta e Detecção de Ameaças

Monitoramento de segurança em ambientes híbridos requer agregação de logs e eventos de múltiplas fontes heterogêneas. SIEMs (Security Information and Event Management) como Splunk, Elastic Security ou soluções nativas de cloud agregam eventos, correlacionam ameaças e automatizam respostas.

A Capital One detectou e respondeu ao infame breach de 2019 através de sistemas automatizados que identificaram acesso anômalo e imediatamente revogaram permissões – embora não tenha sido suficientemente rápido para prevenir exfiltração de dados. Este incidente ressalta que arquiteturas híbridas não são inerentemente mais ou menos seguras que alternativas, mas requerem vigilância e automação consistentes.

Disaster Recovery e Business Continuity

Arquiteturas híbridas oferecem oportunidades únicas para estratégias sofisticadas de disaster recovery e business continuity. A capacidade de distribuir workloads geograficamente entre múltiplos ambientes permite RPOs (Recovery Point Objectives) e RTOs (Recovery Time Objectives) que seriam economicamente inviáveis em infraestrutura tradicional.

Estratégias de DR

Organizações podem escolher entre diferentes níveis de preparação para disaster recovery, cada um com custos e complexidades crescentes:

Backup e Restore mantém cópias de dados em cloud mas requer provisionamento de infraestrutura e restore completo durante desastres. RTOs de horas ou dias são típicos. Custos são mínimos mas downtime é substancial.

Pilot Light mantém versão mínima de ambiente crítico sempre ativo em cloud, pronta para escalar rapidamente durante emergências. Dados são replicados continuamente mas compute resources permanecem em standby. RTOs de minutos a horas são viáveis.

Warm Standby executa versão scaled-down de produção continuamente, processando tráfego não-crítico ou servindo geografias secundárias. Durante desastres, simplesmente escala para capacidade completa. RTOs de minutos são típicos.

Multi-Site Active-Active executa produção completa simultaneamente em múltiplos ambientes, com load balancing distribuindo tráfego. RTOs são essencialmente zero – failover é transparente para usuários. Custos são duplicados mas business continuity é maximizada.

A Netflix opera inteiramente em modelo active-active distribuído globalmente. Se um availability zone inteiro na AWS falhar, tráfego automaticamente rota para zonas remanescentes sem interrupção perceptível de serviço. Este nível de resiliência requer arquitetura fundamentalmente distribuída onde aplicações são stateless e dados são replicados assincronamente com eventual consistency.

Trade-offs Fundamentais e Decisões Estratégicas

Não existe estratégia de cloud universalmente superior. Escolhas arquiteturais representam trade-offs entre objetivos conflitantes – controle versus conveniência, flexibilidade versus padronização, otimização de custos versus time-to-market. Líderes técnicos devem entender estas tensões e fazer escolhas conscientes alinhadas com contexto organizacional específico.

Controle versus Managed Services

Cloud privada oferece controle máximo mas requer que organizações gerenciem undifferentiated heavy lifting (UHL) – patching, backups, scaling, monitoring. Cloud pública oferece managed services que abstraem esta complexidade mas reduzem controle granular e potencialmente introduzem vendor lock-in.

UHL significa tarefas repetitivas e não estratégicas que não geram vantagem competitiva.A questão crítica não é “qual é melhor”, mas “onde controle adicional agrega valor suficiente para justificar complexidade adicional”. Para infraestrutura de database rodando queries analíticas padrões, RDS gerenciado quase sempre supera gestão manual. Para motores de high-frequency trading onde cada microsegundo importa, infraestrutura customizada pode justificar-se.

Flexibilidade versus Padronização

Multi-cloud oferece flexibilidade de escolher best-of-breed services de múltiplos providers e mitiga risco de vendor lock-in. Mas introduz complexidade operacional substancial – múltiplos SDKs para aprender, ferramentas distintas para gestão, skills fragmentados entre equipes.

Padronizar em single cloud simplifica operações e desenvolve expertise profunda, mas cria dependência. Se provider aumenta preços substancialmente ou deprecia serviços críticos, opções são limitadas. A Dropbox descobriu isto migrando de AWS para infraestrutura própria após custos de cloud ameaçaram viabilidade econômica do negócio.

Otimização Prematura versus Technical Debt

Lift-and-shift permite migração rápida mas perpetua technical debt em cloud mais cara. Refactoring completo maximiza benefícios cloud mas atrasa realizando valor e introduz riscos de execução. Como em tantas decisões arquiteturais, extremos raramente são ótimos.

Abordagens pragmáticas aplicam o Strangler Pattern: envolvem o monólito com uma fachada/proxy, capturam o tráfego e migram funcionalidades de forma incremental para serviços cloud-native. Começa-se por um lift-and-shift para colher ganhos imediatos (como eliminar data centers) e, em seguida, componentes são substituídos gradualmente conforme a tese econômica se sustenta. Esse modelo equilibra velocidade com otimização e reduz risco, permitindo aprendizado contínuo durante a transição.

Olhando Adiante: Tendências Emergentes

A evolução de cloud computing não desacelera. Várias tendências emergentes moldarão estratégias de próxima geração nos próximos anos, expandindo possibilidades arquiteturais enquanto introduzem novas complexidades.

Serverless e Function-as-a-Service abstraem infraestrutura quase completamente, permitindo que desenvolvedores foquem exclusivamente em lógica de negócio. AWS Lambda, Azure Functions e Google Cloud Functions cobram apenas por execução real de código, eliminando custos de capacidade ociosa. Adoção cresce rapidamente mas arquiteturas serverless introduzem desafios próprios – cold starts, limites de execução, debugging distribuído.

Cold start é a latência extra ao iniciar recursos que estão “adormecidos”.Confidential Computing protege dados durante processamento, não apenas em trânsito e repouso. Tecnologias como Intel SGX, AMD SEV e ARM TrustZone criam enclaves seguros onde dados são processados encriptados, inacessíveis até para administradores de sistema. Isto pode resolver um dos últimos obstáculos para migração de workloads ultra-sensíveis para cloud pública.

WebAssembly e Edge Computing distribuem computação ainda mais próxima de usuários. Cloudflare Workers, AWS Lambda@Edge e Fastly Compute@Edge executam código em centenas de data centers globalmente, reduzindo latências para single-digit milliseconds. Aplicações que requerem interatividade real-time – gaming, realidade aumentada, autonomous vehicles – dependem crescentemente destas arquiteturas.

AI/ML Model Deployment está forçando reavaliação de onde computação ocorre. Treinar modelos de AI requer compute massivo melhor executado em cloud centralizada com GPUs especializados. Mas inference frequentemente acontece em edge devices para minimizar latência e proteger privacidade. Arquiteturas híbridas onde training ocorre em cloud e inference na edge tornam-se padrão.

Inferência é o processo de usar um modelo já treinado para gerar saídas a partir de novas entradas — classificações, recomendações, respostas, detecções. É a fase de executar um modelo treinado para produzir previsões.Conclusão: Arquitetando para Seu Contexto Específico

Decisões sobre estratégias de cloud são fundamentalmente decisões de negócio disfarçadas de escolhas técnicas. A arquitetura certa depende de regulatory requirements, perfil de workloads, capacidade organizacional, constraints orçamentários e objetivos estratégicos de longo prazo.

Decisões sobre estratégias de cloud são fundamentalmente decisões de negócio disfarçadas de escolhas técnicas.

Organizações que tratam migração para cloud como projeto único – “vamos mover tudo para AWS até fim do ano” – consistentemente sub-realizam potencial. Transformação cloud bem-sucedida é jornada contínua de otimização incremental, aprendizado constante e evolução arquitetural conforme necessidades mudam.

Não existe atalho para devido diligence rigoroso. Comece identificando workloads candidatos, entendendo seus requisitos técnicos e de negócio. Conduza proofs-of-concept limitados antes de comprometer migrações em larga escala. Invista em desenvolver expertise organizacional em cloud, DevOps, infraestrutura-como-código e práticas modernas de engenharia.

Acima de tudo, reconheça que decisões de hoje não são permanentes. Arquiteturas podem e devem evoluir. Aplicações migradas via lift-and-shift hoje podem ser refactored amanhã quando ROI justificar investimento. Private cloud pode fazer sentido temporariamente durante transição de panorama regulatório. Multi-cloud pode ser experimentado gradualmente em workloads não-críticos antes de expansão.

A Capital One e Walmart fizeram escolhas radicalmente diferentes – uma migrando completamente para cloud pública de seu não-competidor, outra construindo infraestrutura privada massiva para evitar dependência de seu maior rival – e ambas estão prosperando. O que importa não é copiar best practices de outras organizações, mas entender profundamente seu contexto específico e arquitetar soluções apropriadas.